TU Wien:Entwurf, Errichtung und Management von Datennetzen VO (Siegl)/Fragenausarbeitung WS10

Typische Fragen (in letzter VO-Einheit genannt)[Bearbeiten | Quelltext bearbeiten]

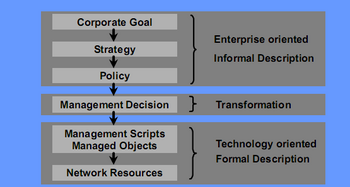

Policy Hierachie[Bearbeiten | Quelltext bearbeiten]

Datei:VO184.149-1.pdf auf seite 3

- Corporate Goal

- Ziel des Unternehmens. Fast immer Gewinnmaximierung oder Gewinnausschüttung. Bei Kapitalgesellschaften (KG) ist Gewinn sogar Pflicht. Es gibt andere Unternehmungen, die andere Ziele haben, etwa ist das Ziel einer Universität im Normalfall Forschung und Lehre. Das Corporate Goal bestimmt den Rahmen für die Strategie.

- Strategy

- Die Strategie ist ein Plan zur Erreichung eines Ziels (des Corporate Goals).

- Policy

- Konkrete Vorgehensweise, Regeln und Bestimmungen zur Umsetzung der Strategie. Auch, was nicht gemacht werden soll oder darf ist in der Policy definiert.

- Management Decision

- Transformiert die informellen Eigenschaften (gegeben durch Goal, verfolgt durch Strategy, implementiert durch Policy) in formale Artefakte.

- Management Scripts und Managed Objects

- Ergebnisse des Transformationsprozesses

- Network Resources

- Auf sie werden Management Scripts und Managed Objects angewendet

Hier könnten fragen kommen wie:

- wo glaubt man in der policy hierachie einzusteigen

- er hat angedeutet, dass er der meinung ist es sei im bereich der transformation

- wie wünscht man sich seine führungspersöhnlichkeit

anmerkung von Dr. Siegl: entscheidungsrichtung kann sich auch umdrehen (dann von unten nach oben) zB wenn eine abteilung sehr mächtig ist oder SAP eingeführt wird.

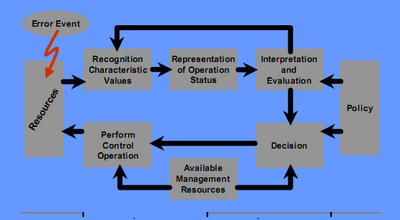

Network management Activity Loop[Bearbeiten | Quelltext bearbeiten]

- Recognition Characteristic Values

- die messung

- Representation of Operation Status

- messung in einen status überführen. probleme kann hier sein: wie stellt man "kein wert konnte gemessen werden" dar (wichtig von anfang an zu berücksichtigen)

- Interpretation and Evaluation

- interpretation was das für das netzwerk bedeutet. dazu einteilung (siehe unten)

- Policy

- sollte von der unternehmensführung abgesegnet sein um probleme zu vermeiden

- Decision

- aufgrund der policy und der interpretation (siehe auch unten) und der verfügbaren resourcen

- Available Management Resources

- verfügbares material (zB: ersatzswitch) und personal (zB jemand der einen switch tauschen kann)

- Perform Control Operation

- aktion am netzwerk um problem zu beheben

Klassifikation der evaluation:

- rot

- sofortiger handlungsbedarf

- orange

- sofort nach ende der aktuellen aufgabe

- gelb

- warnung, bei gelegenheit nachschauen was nicht passt

- grün

- alles passt

- blau

- es kann nicht gemessen werden

- violett

- wartung

schwingen des systems kann durch einen tiefpassfilter vermieden werden. dieser kann dadurch realisiert werden, dass auch ältere informationen berücksichtigt werden und (in summe) wichtiger sind als die aktuelle information.

Mögliche Fragen:

- Auf welchen Aspekt, dargestellt im Diagramm, würden Sie den größten Fokus und die meiste Aufmerksamkeit legen? Antwort: Representation oder Interpretation/Evaluation.

IP-Adressen[Bearbeiten | Quelltext bearbeiten]

IPv4 ... 4 Bytes. Darstellung in Dezimalform getrennt durch einen "."

IPv6 ... 16 Bytes. Darstellung in Hexadezimalform, jeweils zwei Oktetts werden zusammengefasst und in Gruppen durch ":" getrennt. Ein oder mehrere aufeinander folgende Gruppen, deren Wert 0 ist, dürfen ausgelassen und durch einen ":" ersetzt werden (2001:db8:0:0:0:0:1428:57ab = 2001:db8::1428:57ab). Ersetzt darf aber nur einmal werden (bei 2001:db8:0:0:8d3:0:0:0 kann man NICHT 2x ersetzen).

CIDR-Notation ...Classless Inter-Domain Routing. Besteht aus einer IP-Adresse + Suffix. Das Suffix gibt die Anzahl der 1-Bits in der Netzmaske an. Bsp: 172.17.0.0/17 = 172.17.0.0/255.255.128.0. Wird auch bei IPv6 verwendet.

IP-Rechenaufgabe[Bearbeiten | Quelltext bearbeiten]

- Gegeben

- IP-Adresse: 128.130.35.166

- Subnetz-maske: 255.255.224.0

- Gesucht

- netwerkaddresse

- broadcastadresse

--binär--> 128.130.35.166 1000 0000.1000 0010.0010 0011.1010 0110 255.255.224.0 1111 1111.1111 1111.1110 0000.0000 0000 netwerkaddresse 1000 0000.1000 0010.0010 0000.0000 0000 128.130.32.0 broadcastadresse 1000 0000.1000 0010.0011 1111.1111 1111 128.130.63.255 position im netz 11 1010 0110 934 adressbereich 128.130.32.0 - 128.130.63.255 ipv4 bereich zur verwendung 128.130.32.1 - 128.130.63.254

für netzwerkadresse: IP & SM

für broadcastadresse (die höchste adresse des netzwerks): IP | !SM

Liste möglicher Netzmasken[Bearbeiten | Quelltext bearbeiten]

.255, .254, .252., .240, .248, .224, .192. .128, .0

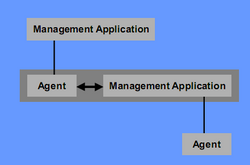

SNMP (PDUs, Elemente, in Topologie verknüpft, 2 Manager(Gefahren) )[Bearbeiten | Quelltext bearbeiten]

Simple Network Management Protocol:

- ursprünglich als übergangslösung gedacht

- keine security

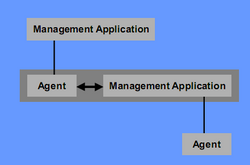

- manager

- agiert als client

- fragt agents ab, gibt befehle an agents

- agent

- agiert als server

- bietet informationen an, kann auf befehle reagieren

- PROBLEM:

- manager reden nur mit agenten

- manager reden nicht untereinander

- agenten reden nicht untereinander

- Mögl. Frage: Welche Gefahren gibts denn, wenn 2 Manager gleichzeitig am Werken sind?

- manager sprechen sich untereinander nicht ab. dadurch kann es zB passieren, dass die beiden manager immer abwechselnd auf den ihrer ansicht nach richtigen wert setzen und damit gegeneinander arbeiten

- LÖSUNG

Dual Role entity - ein Midlevel Manager (name kommt daher, dass er manchen geräten unterstellt anderen überstellt ist) aggiert als Dual Role Entity (ist sowohl Agent als auch Manager)

- der übergeordnete Manager steuert also den Midlevel Manager der für einen bestimmten unterbereich verantwortlich ist.

Bestandteile eines Systems mit SNMP:[Bearbeiten | Quelltext bearbeiten]

- Management Information Base (MIB)

- Darstellung des Gerätezustands mit skalaren Werten und 2D-Array

- Managed Node (Agent)

- Management Station (NMS)

- Management Protokoll (SNMP)

- Protokoll zur Übertragung von MIB

Funktionsweise der MIB:[Bearbeiten | Quelltext bearbeiten]

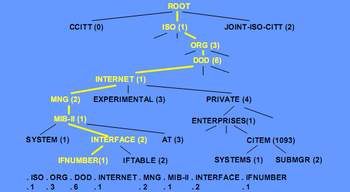

- adressierung mittels baumstruktur und mnemonischem (ein für den Menschen lesbares Kürzel für einen Befehl) und numerischem code

- zu den blättern werden werte gespeichert

wichtige werte in der systems group 1.3.6.1.2.1.1.[Bearbeiten | Quelltext bearbeiten]

- 1 sys Descr

- menschenlesbare beschreibung

- 2 sys ObjectID

- eindeutige kennung des geräts (ist deine eindeutige OID die auf weitere informationen im private/enterprise bereich verweist

- 3 sys uptime

- wird zum erkennen von reboots verwendet

- 4 sys contact

- email-adresse (firmen-email-adresse verwenden, nicht von person, da die person nur für begrenzte zeit für firma arbeitet)

- 5 sys name

- manchmal setbar, manchmal readonly

- 6 sys location

- ort wo sich das gerät befindet

- 7 sys services

- integer der als bitmaske zu interpretieren ist und darstellt welche services aktiv sind ( repeater, switch, router, ...)

wichtige werte in der interface group 1.3.6.1.2.1.2.[Bearbeiten | Quelltext bearbeiten]

- port

- received bytes

- send bytes

Protocol Data Units[Bearbeiten | Quelltext bearbeiten]

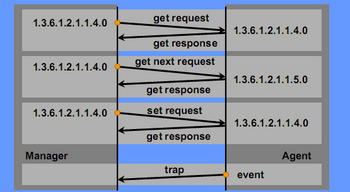

- get_request

- wert abfragen (Antwort: get_response mit wert)

- set_request

- wert setzten (Antwort: get_response mit neuem wert)

- get_next_request

- abfragen der nöchsten OID (Antwort: get_response mit OID und wert des nächsten blatts)

- get_response

- antwort des agent

- trap

- asynchrone nachricht (=ohne anfrage des managers) (alle anderen PDUs sind für synchrone kommunikation) die bei ereignis am agent gesendet wrid (zB up, down, ...)

Security[Bearbeiten | Quelltext bearbeiten]

- ursprünglich nicht vorgesehen

- über "read-only-commutiy-string" (default: public) oder "read-write-community-string" (default: private) ein bisschen security eingebaut

- community strings werden im klartext als teil der PDU übertragen

- ABHILFE: eigenes VLAN für management, security durch netzdesign

Mit SNMP in Version 3 (standardisiert in RFC3411 bis RFC3418) wurden endlich moderne Security-Aspekte eingeführt. So unterstützt SNMPv3 Verschlüsselung und Integrität des Datenverkehrs, sowie Authentifizierung von allen Teilnehmern.

Arten der internen Realisierung eines Instrumentariums[Bearbeiten | Quelltext bearbeiten]

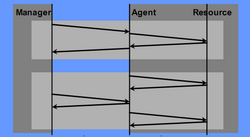

oberer bildteil

- bei der abfrage wird die Ressource ausgelesen und mit dem ergebnis geantwortet

- aktueller wert

- für kurzlebige werte

- Gefahr: gerät ist nur mehr mit management-role (also dem auslesen von werten) beschäftigt und kommt nicht mehr zur primary-role

- Agent/Gerät kann sich nicht aussuchen, wann die Ressource abgefragt wird, Zeitpunkt kann gerade ungünstig sein.

- Gefahr: Antwort des Agents an den Manager dauert zu lang (Agent wartet auf Antwort der Ressource), Timeout des Managers wird überschritten

unterer bildteil:

- peridische ermittlung der werte

- agent ermittelt wert wenn er will (zB bei geringer auslastung durch primary-role)

- wert wird zuwischengespeichert

- bei abfrage wird zwischengespeicherter wert zurückgeliefert (nicht mehr ganz aktuell)

- von vorteil wenn die ermittlung des werts sehr aufwändig ist

Was ist ein Proxy-Agent / Proxy[Bearbeiten | Quelltext bearbeiten]

https://web.archive.org/web/20180730235246/https://www.itwissen.info/Proxy-Agent-proxy-agent.html

Um in einem SNMP-Netzwerkmanagement-System Komponenten einbinden und kontrollieren zu können, die nicht SNMP-fähig sind, bietet SNMP eine Funktion zur Bildung von Proxy-Agenten. Der Proxy-Agent simuliert eine entsprechende Funktion und übernimmt die Aufgabe eines SNMP-Agenten gegenüber dem Netzwerkmanagement, indem er die Instruktionen entsprechend umsetzt.

Bei der SNMP-Proxy-Implementierung wird das Protokoll einer proprietären Management-Einheit in das SNMP-Protokoll umgesetzt. Der Proxy-Agent verschafft so der SNMP-Management-Station ein einheitliches Bild.

ein Proxy ist im allgemeinen ein verbindendes element zwischen zwei welten (zB zwischen LAN und feldbus in der haustechnik)

Dual-Role-Entity[Bearbeiten | Quelltext bearbeiten]

siehe SNMP (frage weiter oben, auszug folgt):

...

- ein Midlevel Manager (name kommt daher, dass er manchen geräten unterstellt anderen überstellt ist) aggiert als Dual Role Entity (ist sowohl Agent als auch Manager)

- der übergeordnete Manager steuert also den Midlevel Manager der für einen bestimmten unterbereich verantwortlich ist.

...

Mögliches Problem:

Bei Überlastung entscheidet sich eine Dual Role Entity meist für die Aufrechterhaltung eines der beiden Dienste. Dieser ist der Primär-Dienst (zb drucken bei Drucker), der andere der Sekundär-Dienst (zb SNMP-Service des Drucker)

Wie funkioniert ein Switch[Bearbeiten | Quelltext bearbeiten]

Im Folgenden wird, sofern nicht anders gekennzeichnet, von Layer-2-Switches ausgegangen. Die einzelnen Ports eines Switches können unabhängig voneinander Daten empfangen und senden. Diese sind entweder über einen internen Hochgeschwindigkeitsbus (Backplane-Switch) oder kreuzweise miteinander verbunden (Matrix Switch). Datenpuffer sorgen dafür, dass nach Möglichkeit keine Datenframes verloren gehen.

Ein Switch muss im Regelfall nicht konfiguriert werden. Empfängt er ein Paket nach dem Einschalten, speichert er die MAC-Adresse des Senders und die zugehörige Schnittstelle in der Source-Address-Table (SAT).

Wird die Zieladresse in der SAT gefunden, so befindet sich der Empfänger im an der zugehörigen Schnittstelle angeschlossenen Segment. Das Paket wird dann an diese Schnittstelle weitergeleitet. Sind Empfangs- und Zielsegment identisch, muss das Paket nicht weitergeleitet werden, da die Kommunikation ohne Switch im Segment selbst stattfinden kann. Falls die Zieladresse (noch) nicht in der SAT ist, muss das Paket an alle anderen Schnittstellen weitergeleitet werden. In einem IPv4-Netz wird der SAT-Eintrag meist während der sowieso nötigen ARP-Adressenanfragen vorgenommen. Zunächst wird aus der ARP-Adressenanfrage eine Zuordnung der Absender-MAC-Adresse möglich, aus dem Antwortpaket erhält man dann die Empfänger-MAC-Adresse. Da es sich bei den ARP-Anfragen um Broadcasts handelt und die Antworten immer an bereits erlernte MAC-Adressen gehen, wird kein unnötiger Verkehr erzeugt. Broadcast-Adressen werden niemals in die SAT eingetragen und daher stets an alle Segmente weitergeleitet. Pakete an Multicast-Adressen werden von einfachen Geräten wie Broadcasts verarbeitet. Höher entwickelte Switche beherrschen häufig den Umgang sowie die Verarbeitung von Multicasts und senden Multicast-Pakete dann nur an die registrierten Multicast-Adress-Empfänger.

Switches lernen also gewissermaßen die MAC-Adressen der Geräte in den angeschlossenen Segmenten automatisch.

Unterschiedliche Arbeitsweisen[Bearbeiten | Quelltext bearbeiten]

Ein Ethernet-Paket enthält die Zieladresse in den ersten 48 Bits (6 Bytes) nach der so genannten Datenpräambel. Mit der Weiterleitung an das Zielsegment kann also schon nach Empfang der ersten sechs Bytes begonnen werden, noch während das Paket empfangen wird. Ein Paket ist 64 bis 1518 Bytes lang, in den letzten vier Bytes befindet sich zur Erkennung von fehlerhaften Paketen eine CRC-Prüfsumme (zyklische Redundanzprüfung). Datenfehler in Paketen können also erst erkannt werden, nachdem das gesamte Paket eingelesen wurde.

Je nach den Anforderungen an die Verzögerungszeit und Fehlererkennung kann man daher Switches unterschiedlich betreiben:

- Cut-Through – Eine sehr schnelle Methode, wird hauptsächlich von besseren Switches implementiert. Hierbei schaut der Switch beim eingetroffenen Paket nur auf die Ziel-MAC-Adresse, trifft eine Weiterleitungsentscheidung und schickt das Paket entsprechend weiter. Um Zeit zu sparen wird das Paket nicht auf Fehlerfreiheit geprüft. Der Switch leitet deshalb auch beschädigte Pakete weiter, diese müssen dann durch andere Schicht-2-Geräte oder höhere Netzwerkschichten aufgefangen werden. Die Latenzzeit in Bit beträgt hier 112. Sie setzt sich aus der Präambel (8 Byte) und der Ziel-MAC-Adresse (6 Byte) zusammen.

- Store-and-Forward – Die grundlegendste, aber auch langsamste Switch-Methode mit der größten Latenzzeit. Sie wird von jedem Switch beherrscht. Der Switch empfängt zunächst das ganze Paket (speichert diesen; „Store“), trifft wie gehabt seine Weiterleitungsentscheidung anhand der Ziel-MAC-Adresse und berechnet dann eine Prüfsumme über das Paket, das er mit dem am Ende des Paketes gespeicherten CRC-Wert vergleicht. Sollten sich Differenzen ergeben, wird das Paket verworfen. Auf diese Weise verbreiten sich keine fehlerhaften Pakete im lokalen Netzwerk. Store-and-Forward war lange die einzig mögliche Arbeitsweise, wenn Sender und Empfänger mit verschiedenen Übertragungsgeschwindigkeiten oder Duplex-Modi arbeiteten oder verschiedene Übertragungsmedien nutzen. Die Latenzzeit in Bit ist hier identisch mit der Paketlänge, bei Ethernet und Fast Ethernet sind es folglich mindestens 512 Bit, bei Gigabit Ethernet mindestens 4096 Bit, Obergrenze ist die MTU in Bit (~ 12.000 Bit). Heute gibt es auch Switches, die einen Cut-and-Store-Hybridmodus beherrschen, der vor allem beim Switchen von schnell nach langsam beschleunigend wirkt.

- Fragment-Free – Schneller als Store-and-Forward, aber langsamer als Cut-Through. Anzutreffen vor allem bei besseren Switches. Prüft, ob ein Paket die im Ethernet-Standard geforderte minimale Länge von 64 Bytes (512 Bit) erreicht und schickt es dann sofort auf den Zielport, ohne eine CRC-Prüfung durchzuführen. Fragmente unter 64 Byte sind meist Trümmer einer Kollision, die kein sinnvolles Paket mehr ergeben.

- Error-Free-Cut-Through/Adaptive Switching – Eine Mischung aus mehreren der obigen Methoden. Wird ebenfalls meist nur von teureren Switches implementiert. Der Switch arbeitet zunächst im „Cut through“-Modus und schickt das Paket auf dem korrekten Port weiter ins LAN. Es wird jedoch eine Kopie des Paketes im Speicher behalten, über die dann eine Prüfsumme berechnet wird. Stimmt sie nicht mit der im Paket überein, so kann der Switch dem defekten Paket zwar nicht mehr hinterhersignalisieren, dass es falsch ist, aber er kann einen internen Zähler mit der Fehlerrate pro Zeiteinheit hochzählen. Wenn zu viele Fehler in kurzer Zeit auftreten, fällt der Switch in den Store-and-Forward-Modus zurück. Wenn die Fehlerrate wieder niedrig genug ist, schaltet er in den Cut-through-Modus um. Ebenso kann der Switch temporär in den Fragment-Free-Modus schalten, wenn zuviele Fragmente mit weniger als 64 Byte Länge ankommen. Besitzen Sender und Empfänger unterschiedliche Übertragungsgeschwindigkeiten oder Duplex-Modi bzw. nutzen andere Übertragungsmedien (Glasfaser auf Kupfer), so muss ebenfalls mit Store-and-Forward Technik geswitcht werden.

Heutige nach dem Client-/Server-Prinzip arbeitende Netzwerke unterscheiden zwei Architekturen: das symmetrische und asymmetrische Switching gemäß der Gleichförmigkeit der Anschlussgeschwindigkeit der Ports. Im Falle eines asymmetrischen Switchings, d.h. wenn Sende- und Empfangsports unterschiedliche Geschwindigkeiten aufweisen, kommt das Store-and-Forward-Prinzip zum Einsatz. Bei symmetrischem Switching also der Kopplung gleicher Ethernetgeschwindigkeiten wird nach dem Cut-Through-Konzept verfahren.

Mehrere Switches in einem Netzwerk[Bearbeiten | Quelltext bearbeiten]

Bis zur Einführung von Gigabit-Ethernet (1000BaseTX) erfolgte die Verbindung mehrerer Switches entweder über einen speziellen Uplinkport oder über ein gekreuztes Kabel (crossover cable), neuere Switches wie auch alle Gigabit-Ethernet Switches beherrschen Auto-MDI(X), sodass diese auch ohne spezielle Kabel miteinander gekoppelt werden können. Oft, aber nicht notwendigerweise sind Uplink-Ports in einer schnelleren oder höherwertigen (Ethernet-) Technologie realisiert als die anderen Ports (z. B. Gigabit-Ethernet statt Fast Ethernet oder Glasfaserkabel anstatt Twistedpair-Kupferkabel). Im Unterschied zu Hubs können nahezu beliebig viele Switches miteinander verbunden werden. Die Obergrenze hat hier nichts mit einer maximalen Kabellänge zu tun, sondern hängt von der Größe der Adresstabelle (SAT) ab. Bei aktuellen Geräten der Einstiegsklasse sind oft 500 Einträge (oder mehr) möglich, das begrenzt die maximale Anzahl von Knoten (~Rechnern) auf ebendiese 500. Kommen mehrere Switches zum Einsatz, so begrenzt das Gerät mit der kleinsten SAT die maximale Knotenanzahl. Hochwertige Geräte können leicht mit mehreren tausend Adressen umgehen. Wird die maximale Zahl überschritten, so passiert das gleiche wie beim MAC-Flooding, folglich bricht die Performance drastisch ein.

Zur Steigerung der Ausfallsicherheit können Verbindungen redundant aufgebaut werden. Dabei werden der doppelte Transport von Paketen und Switching-Schleifen durch die vorherige Ausführung des Spanning Tree Protocol (STP) verhindert. Eine andere Möglichkeit, ein Netz mit Schleifen redundant zu machen und gleichzeitig die Leistung zu steigern, ist das Meshing. Hier dürfen beliebige Schleifen zwischen meshingfähigen Geräten gebildet werden; zur Leistungssteigerung können dann für Unicast-Datenverkehr (ähnlich wie beim Trunking) alle Schleifen (auch Teilschleifen) weiter genutzt werden (es wird kein Spannbaum gebildet). Multicast und Broadcast müssen vom Meshing-Switch gesondert behandelt werden und dürfen nur auf einer der zur Verfügung stehenden vermaschten Verbindungen weitergeschickt werden. Ethernet-Switches, die Meshing unterstützen, kommen unter anderem von Avaya/Nortel oder HP.

Eine bessere Nutzung von doppelt ausgeführten Verbindungen ist die Port-Bündelung (engl.: trunking, bonding, etherchannel – je nach Hersteller), wodurch bis zu acht [2009] gleichartige Verbindungen parallel geschaltet werden können, um die Geschwindigkeit zu steigern. Diese Technologie beherrschen professionelle Switches, die auf diese Weise untereinander, von Switch zu Switch, oder aber von Switch zu Server verbunden werden können. Der Standard ist mittlerweile verabschiedet IEEE 802.1AX-2008, nur ist [2009] nach wie vor das Zusammenschalten von Switches verschiedener Hersteller problematisch.

Stacking ist im Switching-Umfeld eine Technik, mit der aus mehreren unabhängigen, stacking-fähigen Switches ein gemeinsamer logischer Switch mit höherer Portanzahl und gemeinsamem Management konfiguriert wird. Stacking-fähige Switches verfügen über besondere Ports, die sogenannten Stacking-Ports, welche üblicherweise mit besonders hoher Übertragungsrate und geringer Latenzzeit arbeiten. Beim Stacking werden die Switches, die in der Regel vom gleichen Hersteller und aus der gleichen Modellreihe stammen müssen, mit einem speziellen Stack-Kabel miteinander verbunden. Eine Stacking-Verbindung ist normalerweise die schnellste Verbindung zwischen mehreren Switches und überträgt neben Daten auch Managementinformationen. Solche Schnittstellen können durchaus teurer sein als Standard-HighSpeed-Ports, die natürlich ebenfalls als Uplinks genutzt werden können; Uplinks sind immer möglich, aber: nicht alle Switches unterstützen das Stacking.

Spanning Tree Protocol[Bearbeiten | Quelltext bearbeiten]

Das Spanning Tree Protocol (STP, deutsch: Spannbaum-Protokoll) baut einen Spannbaum zur Vermeidung redundanter Netzpfade (Schleifen) im LAN, speziell in geswitchten Umgebungen, auf. Mittlerweile wurde das klassische STP durch RSTP nach IEEE 802.1D-2004 ersetzt.

Netze sollten auf der Sicherungsschicht zu jedem möglichen Ziel immer nur einen Pfad haben, also keine Schleifen enthalten, um zu vermeiden, dass Datenpakete (Frames) dupliziert werden und mehrfach am Ziel eintreffen, was zu Fehlfunktionen in darüber liegenden Netzwerkschichten führen und die Leistung des Netzes vermindern oder sogar zu einem Komplettausfall führen könnte. Andererseits werden mitunter redundante Netzpfade als Backup für den Fehlerfall (Ausfall einer Strecke) verwendet. Das Spanning Tree Protocol wird beiden Bedürfnissen gerecht.

Zur Kommunikation zwischen den Switches wird das Bridge-Protokoll genutzt. Die Pakete dieses Protokolls werden Bridge Protocol Data Unit (BPDU) genannt. Sie werden im Datenfeld eines Ethernet-Datenpaketes (Ethernet-Frame) per Broadcast an die benachbarten Switches versendet.

Zunächst wird unter den Spanning-Tree-fähigen Bridges im Netz eine sog. Root Bridge gewählt, die die Wurzel des aufzuspannenden Baumes wird und „Chef” des Netzes ist. Dies geschieht, indem alle Bridges ihre Bridge-ID (kurz: BID; jede Bridge wird über eine eigene BID identifiziert) an eine bestimmte Multicast-Gruppe mitteilen. Die Bridge-ID ist 8 Byte lang (2 Byte Bridge Priority, 6 Byte MAC-Adresse). Die Bridge mit der „niedrigsten“ Priorität wird zur Root Bridge. Sollte die Bridge Priority identisch sein, wird als ergänzendes Kriterium die MAC-Adresse der Komponenten benutzt (auch hier gewinnt wieder die Bridge mit der niedrigeren Zahl).

Von der Root Bridge aus werden nun Pfade festgelegt, über die die anderen Bridges im Netz erreichbar sind. Sind redundante Pfade vorhanden, so müssen die dortigen Bridges den entsprechenden Port deaktivieren. Die Pfade, über die kommuniziert werden darf, werden anhand von Pfadkosten bestimmt, die die dortige Bridge übermittelt.

Diese Pfadkosten sind abhängig vom Abstand zur Root Bridge und dem zur Verfügung stehenden Uplink zum Ziel. Ein 10-Mbit/s-Uplink hat üblicherweise höhere Pfadkosten als ein 100-Mbit/s-Uplink zum gleichen Ziel, die 10-Mbit-Verbindung würde daher als redundanter Pfad geblockt werden. Die Pfadkosten sind nach IEEE-Vorgaben genormt, können aber manuell abweichend festgelegt werden, beispielsweise um bei gleicher Geschwindigkeit einen bevorzugten Uplink auszuwählen, um so die reellen Kosten von WAN-Verbindungen widerzuspiegeln. Auf diese Weise ist jedes Teilnetz im geswitchten LAN nur noch über eine einzige, der Designated Bridge, erreichbar. In der grafischen Darstellung ergibt sich ein Baum aus Netzpfaden, der dem Algorithmus sowie dem Protokoll seinen Namen gab.

Die Root Bridge teilt den in der Hierarchie eine Stufe unterhalb liegenden Designated Bridges im Abstand von zwei Sekunden mit, dass sie noch da ist, woraufhin die empfangende Designated Bridge ebenfalls an nachfolgende Bridges die entsprechende Information senden darf. Wenn diese Hello-Pakete ausbleiben, hat sich folglich an der Topologie des Netzes etwas geändert, und das Netz muss sich reorganisieren. Diese Neuberechnung des Baumes dauert im schlimmsten Fall bis zu 30 Sekunden. Während dieser Zeit dürfen die Spanning-Tree-fähigen Bridges außer Spanning-Tree-Informationen keine Pakete im Netz weiterleiten. Dies ist einer der größten Kritikpunkte am klassischen Spanning-Tree-Protokoll, da es möglich ist, mit gefälschten Spanning-Tree-Paketen eine Topologieänderung zu signalisieren und das gesamte Netz für bis zu 30 Sekunden lahmzulegen. Um diesen potenziellen Sicherheitsmangel zu beheben, aber auch um bei echten Topologieänderungen das Netz schnell wieder in einen benutzbaren Zustand zu bringen, wurden schon früh von verschiedenen Herstellern Verbesserungen an der Implementierung des Spanning Tree Protokolls bzw. der dazu verwendeten Algorithmen entwickelt. Eine davon, das Rapid Spanning Tree Protocol (RSTP), ist inzwischen zum offiziellen IEEE-Standard 802.1w geworden.

Spanning Tree Protocol - Schritt für Schritt[Bearbeiten | Quelltext bearbeiten]

- Power-Up aller Bridges

- Bridges stellen all ihre Anschlüsse auf Blocked

- Jede Bridge nimmt an, sie sei Root-Bridge und sendet BPDUs (Bridge Protocol Data Unit) aus

- Bridge mit kleinster BridgeID wird zur Root-Bridge (ID: PrioFeld + Teil der MAC)

- Aussenden von Konfigurations-BPDUs durch die Root-Bridge

- Jede Bridge bestimmt einen Root-Port (Port mit kleinsten Pfadkosten zur Root-Bridge. Bei Ports mit gleichen Kosten gewinnt die kleinere PortID)

- Bestimmen der Designated Bridge (LAN wählt die Designated-Bridge. Bridge mit Root-Port ins LAN mit den niedrigsten Pfadkosten)

Nach welchen Kriterien ist IP aufgebaut. Wie ist der Zusammenhang mit DNS (Toplogisch vs Organisatorisch)[Bearbeiten | Quelltext bearbeiten]

Die Frage ist nicht ganz klar, daher eher allgemeines.

Die Toplogie von DNS gleicht einer Pyramide. Ganz oben befinden sich die root-Server, deren IP-Adressen in jeder DNS-Software fix konfiguriert sind (meist bereits in der example config enthalten). Diese haben jeweils eine Zone für die existierenden Top Level Domains (com, net, org, de, at, ru, etc..), kurz TLDs, eingetragen. In der Zone sind wiederum die IP-Adressen der Nameserver eingetragen, die für diese TLD zuständig sind. In den Nameserver der einzelnen TLDs sind die registrierten Domains eingetragen (ebenfalls als Zone). Auch hier sind wieder ausschließlich die Nameserver des zuständigen Domainbetreibers eingetragen (z.b. die Nameserver des Webhosting Unternehmens). Das Spiel kann man technisch gesehen ewig weiter spielen, für gewöhnlich endet es aber im nächsten Schritt, da im Nameserver des Domainbetreibers für die Subdomainen (www., ftp., tiss., etc...) anstatt einer weiteren Nameserver-Referenz, andere Records verwendet werden, die eben die Auflösung beenden. Den letzte Nameserver nennt man auch authoritiven Nameserver.

Nameserver Lookup funktioniert ähnlich:

- Client fragt bei dem ihm bekannten Nameserver (typischerweise der des Providers) nach der Auflösung der Domain bla.xxx.com

- Provider-Nameserver fragt com-Nameserver nach bla.xxx.com. com-Nameserver antwortet mit der IP-Adresse des Nameservers von xxx.com.

- Provider-Nameserver fragt xxx.com-Nameserver nach bla.xxx.com. xxx.com-Nameserver kennt die Zone, in der Zone ist die Subdomain bla enthalten, xxx.com-Nameserver kann daher direkt die Antwort für bla.xxx.com zurück liefern

- Provider-Nameserver gibt Antwort an Client weiter

Bei nicht-authoritiven Nameservern unterscheidet man zwischen iterativen und rekursiven Resolvern (Resolver ... zb der Provider-Nameserver):

- Der Provider Nameserver arbeiter rekursiv ... er nimmt eine Anfrage entgegen und arbeitet alles ab.

- Die einzelnen Nameserver im oben genannten Lookup (abgesehen vom letzten, weil authoritiv) arbeiten iterativ ... sie verweisen auf einen anderen Nameserver

DNS besitzt verschiedene Records (Eintrag im Zone-File):

- A-Record ...IPv4

- AAAA-Record ...IPv6

- NS-Record ...Nameserver Referenz

- MX-Record ...Mailexchange (hostname des mailserver)

- CNAME-Record ...Alias (kanonischer name, zb ftp. cname www. -> ftp hat selbe antwort wie www)

- TXT-Record ...Texteintrag. wird zb verwendet für DKIM (Mail signieren)

- SRV-Record ...Service Record. wird für diverse services verwendet (zb zum server finden bei jabber)

- PTR-Record ...Dient zum auflösen von IP-Adresse zu Domainnamen (umgekehrter weg). Bei dieser speziellen DNS-Anfrage werden die Bytes der IP-Adresse umgedreht und die spezielle Zone "in-addr.arpa" angehängt. Bsp: 192.168.0.1 -> 1.0.168.192.in-addr.arpa. Nach dieser Domain wird anschließend beim root-Nameserver angefragt.

Einige Records wie MX und SRV unterstützen die Angabe einer Priorität (Zahlenwert). Kleinerer Wert -> höhere Priorität.

Für gewöhnlich cached sowohl das OS als auch ein rekursiver Resolver die DNS Antworten. Daher ist DNS auch eine verteilte Datenbank. Um eine Änderung zu propagieren, hat jede Zone (bzw ein Record) auch einen TTL-Wert. Nach Ablauf dieser Zeitspanne wird der gecachte Wert für ungültig erklärt.

DNS bietet die Möglichkeit mehrere zuständige Nameserver zu hinterlegen (zb gibt es viele root.Server, verteilt um die ganzen Welt). Dementsprechend ist in fast jeder erhältlichen DNS-Software eine Möglichkeit zum synchronisieren zwischen Master- und Slave-Nameserver vorgesehen. Üblicherweise geschieht dies über einen Zone-Transfer (=Transfer der ganzen Zone, also aller Records der Domain), den sich der Slave selbst vom Master abholt. Der Slave weiß, wann eine Zone ungültig indem er den Zone-Counter vom Master mit seinem Stand vergleicht. Ist letzterer höher, muss die Zone neu transferiert werden.

Zurück zum Thema des Topics.... Wir sehen also, DNS ist pyramidenförmig aufgebaut, wobei sich ganz unten die Zonen der einzelnen Domain-Betreiber befinden.

Die Topologie von IP ist im Gegensatz zu DNS nicht geordnet. IP (IPv4) besteht aus 4 Bytes (32 Bits), dargestellt in Dezimalform meist durch einen "." getrennt. Durch eine dazugehörige Netzmaske wird eine IP in einen Netzteil und einen Geräteteil getrennt. Die Netzmaske gibt dabei an, an welchem Bit die Trennung erfolgt. Die Information, ob ein Gerät im gleichen Subnetz liegt, wird von einem Host benötigt, um Routing-Entscheidungen treffen zu können.

Will ein Gerät ein IP-Paket versenden, werden die Netzwerkteile der Quell-IP-Adresse und Ziel-IP-Adresse verglichen. Stimmen sie überein, befindet sich der Ziel-Host im selben Netz und das Paket wird direkt an den Empfänger gesendet. Im Falle von Ethernet-Netzen dient das ARP (Address Resolution Protocol) zum Auffinden der Hardwareadresse. Das ARP arbeitet auf der zweiten Schicht des OSI-Modells und stellt die Verbindung zur ersten Schicht her.

Stimmen die Netzwerkteile dagegen nicht überein, so wird über eine Routingtabelle die IP-Adresse eines Routers (next hop) gesucht und das Paket an diesen Router gesendet. Dieser hat über eine oder mehrere Schnittstellen Kontakt zu anderen Netzen und routet das Paket mit demselben Verfahren weiter – er konsultiert dazu seinerseits seine eigene Routingtabelle und sendet das Paket gegebenenfalls an den nächsten Router oder an das Ziel. Bis zum Endgerät kann das Paket viele Netze und Router durchlaufen. Das Durchlaufen eines Routers wird auch Hop (Sprung) genannt, das Routingverfahren Next Hop Routing.

Routing im Internet funktioniert über das Border Gateway Protokoll (BGP, Layer 3). Jeder der einen IP-Bereich von einer Registry zugeteilt bekommt, erhält automatisch ein sogenanntes Autonomes System (AS, zb AS1234). BGP beschreibt nun wie das Routing zwischen den autonomen Systemen statt finden soll (auch eBGP, external BGP, genannt). BGP ist ein Pfadvektorprotokoll und arbeitet auf TCP-Ebene. Bei BGP sendet ein Router regelmäßig an alle seine Nachbarn (die werden natürlich nicht automatisch erkannt, sondern müssen konfiguriert werden, zb nachdem man eine leitung bei der telekom eingekauft hat) sogenannte UPDATE-Paketen, in denen steht, welche Abschnitte des Internets er erreichen kann (via CIDR Notation, siehe IP). Zudem ist das dazugehörige AS und zusätzliche Attribute die zB die Priorität seiner Verbindung beschreibt, vermerkt. BGP sendet auch Nachrichten, wenn eine Route verloren geht.

Da dementsprechend jeder BGP-Router über Routen-Informationen von anderen, insbesondere der benachbarten BGP-Routern verfügt, baut sich jeder BGP-Router eine Datenbank für die Routen zu allen erreichbaren autonomen Systemen auf. Die Größe der Tabelle mit den Routen-Informationen lag Ende 2005 bei ca. 170.000 Einträgen bei über 26.000 autonomen Systemen.

Wieder zurück zum Thema des Topics.... Wir sehen also, IP (speziell IP im Internet) hat dank BGP keine starre Struktur und gleicht einem Spinnennetz. Die Redundanz wird bei IP über mehrere alternative Pfade erreicht. Bei DNS über alternative Server.

Was ist ein VLAN (Dynamisch zuordnen, Trunk)[Bearbeiten | Quelltext bearbeiten]

http://de.wikipedia.org/wiki/Virtual_Local_Area_Network

Ein Virtual Local Area Network (VLAN) ist ein logisches Teilnetz innerhalb eines Switches oder eines gesamten physischen Netzwerks. Es kann sich über einen oder mehrere Switches hinweg ausdehnen. Ein VLAN trennt physische Netze in Teilnetze auf, indem es dafür sorgt, dass VLAN-fähige Switche Frames (Datenpakete) eines VLANs nicht in ein anderes VLAN weiterleiten und das, obwohl die Teilnetze an gemeinsame Switches angeschlossen sein können.

- VLAN liegt auf Layer#2

- ein VLAN hat eine eindeutige ID (bei günstigen switches 1 - 1024, aber auch bis 4096 rauf)

- Wird hauptsätzlich eingesetzt um die Sicherheit des Netzes zu erhöhen (MAC-Flooding, MAC-Spoofing, sich einfach eine fremde IP schnappen, etc..)

- bsp: dhcp server an einem switch port schickt seine pakete über den broadcast (=an alle teilnehmer des netzes). üblicherweise will man den dhcp server aber nur für einige wenige teilnehmer des netzes -> man legt dhcp server + die teilnehmer in ein gemeinsames vlan.

- jedes vlan hat üblicherweise auf layer3 eine netmask, eine broadcast adresse, einen gateway (am router dann, um andere netze zu erreichen)

- vlan heutzutage = IEEE 802.1Q

Zuordnung:

- statisch: über die managament console (telnet, ssh). direkt auf die einzelnen Ports des Switches (e.g. switch port #1 + port #5 -> vlan 100)

- dynamisch: über ne management software, die beispielsweise die mac adresse des rechners am port zu nem vlan zuweist. oder zb über den eingeloggten benutzer am rechner.

- es kann immer nur 1 vlan auf einen port zugewiesen werden

- wenn mehr vlans zugewiesen werden sollen, müssen die anderen vlans "tagged" werden (=vlan id im paket)

- trunk port = mehrere vlans auf einem port. wird u.a. verwendet um ein vlan auf ein anderes switch zu verlängern. auf beiden switches muss das vlan eingerichtet sein (einfach ein vlan mit der selben id anlegen) und dem port zugewiesen werden (entweder tagged oder untagged). bei tagged: das ausgehende switch tagged das paket mit der vlanid. das eingehende erkennt den tag und bearbeitet das paket weiter.

- tagging kann auch eingesetzt werden wenn ein server/rechner mehrere ips haben sollen, die in verschiedenen vlans liegen. hier muss das OS ebenfalls tagging unterstützen und das netzwerk interface entsprechend gesetzt werden.

- summary: wenn ein vlan auf einem port als tagged konfiguriert wird, muss es auf der anderen seite ebenfalls so konfiguriert werden

Cisco VLAN Trunking Protocol (VTP)

- proprietäres protokoll auf layer 2 basis, das die automatische verteilung der vlan konfiguration auf alle switches unterstützt. hierzu gibt es ein master switch, rest sind slaves, die die konfiguration vom master switch erhalten

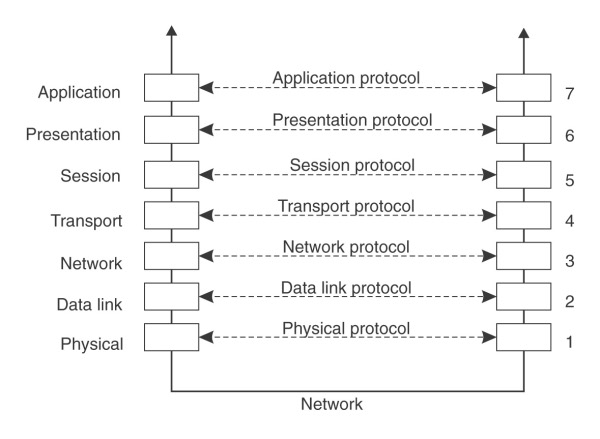

OSI 7 Schichten Modell bis Layer 4[Bearbeiten | Quelltext bearbeiten]

- Physical Layer (Layer #1, Bitübertragungsschicht)

- Diese Schicht stellt mechanische, elektrische und weitere funktionale Hilfsmittel zur Verfügung, um physikalische Verbindungen zu aktivieren bzw. deaktivieren, sie aufrechtzuerhalten und Bits darüber zu übertragen.

- Vertreter: Kupfer/Glas-Verbindung, Stecker, Buchse, Repeater, Hub

- Einheit: Bits

- Datalink Layer (Layer #2, Sicherungsschicht)

- Aufgabe der Sicherungsschicht ist es, eine zuverlässige, das heißt weitgehend fehlerfreie Übertragung zu gewährleisten und den Zugriff auf das Übertragungsmedium zu regeln. Dazu dient das Aufteilen des Bitdatenstromes in Blöcke und das Hinzufügen von Folgenummern und Prüfsummen. Fehlerhafte, verfälschte oder verlorengegangene Blöcke können vom Empfänger durch Quittungs- und Wiederholungsmechanismen erneut angefordert werden. Die Blöcke werden auch als Frames oder Rahmen bezeichnet.

- Vertreter: Switch, Ethernet, Mac-Adresse

- Einheit: Frames

- Network Layer (Layer #3, Vermittlungsschicht)

- Die Vermittlungsschicht sorgt für die Weitervermittlung von Datenpaketen. Die Datenübertragung geht jeweils über das gesamte Kommunikationsnetz hinweg und schließt die Wegesuche (Routing) zwischen den Netzknoten mit ein. Da nicht immer eine direkte Kommunikation zwischen Absender und Ziel möglich ist, müssen Pakete von Knoten, die auf dem Weg liegen, weitergeleitet werden. Weitervermittelte Pakete gelangen nicht in die höheren Schichten, sondern werden mit einem neuen Zwischenziel versehen und an den nächsten Knoten gesendet.

- Zu den wichtigsten Aufgaben der Vermittlungsschicht zählt das Bereitstellen netzwerkübergreifender Adressen, das Routing bzw. der Aufbau und die Aktualisierung von Routingtabellen und die Fragmentierung von Datenpaketen.

- Vertreter: Router, Layer-3-Switch, IP, IPsec

- Einheit: Packets

- Transport Layer (Layer #4, Transportschicht)

- Zu den Aufgaben der Transportschicht zählen die Segmentierung des Datenstroms und die Stauvermeidung. Die Transportschicht bietet den anwendungsorientierten Schichten 5 bis 7 einen einheitlichen Zugriff, so dass diese die Eigenschaften des Kommunikationsnetzes nicht zu berücksichtigen brauchen.

- Vertreter: TCP, UDP

- Einheit: Segmente

EN50173 Verkabelungstopologie (50m, 100m, ...)[Bearbeiten | Quelltext bearbeiten]

Europäische Norm, in der Standortverteiler, Gebäudeverteiler, Etagenverteiler, Kabelverteiler und Endknotenanschluss definiert sind. Hier ist die Skizze wichtig, in der Standortverteiler (SV), Gebäudeverteiler (GV), Etagenverteiler (EV), Kabelverteiler (KV) und Endknoten-/Telekommunikationsanschluss (TA) in Abhängigkeit von einander dargestellt werden. Siehe http://de.wikipedia.org/wiki/Strukturierte_Verkabelung und https://web.archive.org/web/20180730235249/http://www.elektronik-kompendium.de/sites/net/0908031.htm

Fragen dazu:

- Welche Kabelarten werden wo verwendet? Warum? Z.B. LWL zwischen SV und GV, LWL zwischen GV und EV, Kupfer zwischen EV und KV/TV.

- Wie lange dürfen welche Kabel sein? Z.B. 90m für Kupfer verlegt ("permanent link") und je 5m Patchkabel an den Enden.

Unterschied Channel - Link[Bearbeiten | Quelltext bearbeiten]

auch so eine Frage wo man kaum was schreiben kann...

Folgende Darstellung bitte vorstellen:

/---------\ /-----------\

| switch | | panel |

| | | |

| buchse|<stecker------------------------stecker>|buchse |===|

\---------/ \-----------/ |

|

|

|

/---------\ /----------\ |

| pc | | dose | |

| | | | |

| buchse|<stecker-------------------------stecker>|buchse |===|

\---------/ \----------/

Channel ...Umfasst die gesamte Verkabelung. Also ab dem Stecker beim Switch bis zum Stecker beim PC.

Permanent Link ...Umfasst die "fixe" Verkabelung. Also die Verkabelung zwischen Panel und Dose.

Cat 5, 6, 6a, 7 ...bezieht sich auf die Einzelkomponenten (Buchse, Stecker, Kabel, etc..)

Class D E E_A F ...bezieht sich auf die Qualität/max. Bandbreite des Channels, also einer gesamten Verkabelung.

Kupferkabel kann nicht mehr als 90m ohne aktive Komponente verlegt werden

Aufbau eines Twisted Pair Kabels[Bearbeiten | Quelltext bearbeiten]

http://de.wikipedia.org/wiki/Twisted-Pair-Kabel

http://de.wikipedia.org/wiki/%C3%9Cbersprechen

Twisted-Pair-Kabel enthalten vier Adernpaare aus je zwei miteinander verdrillten (englisch twisted) Paaren (englisch pair) von Einzeladern.

Die verdrillung schützt gegen beeinflussung durch crosstalk (siehe unten). die einzeilnen paare sind aus dem selben grund miteinander verseilt.

Bezeichnungsschema[Bearbeiten | Quelltext bearbeiten]

Bezeichnungs der Form XX/YTP eingeführt (TP für Twisted Pair).

Dabei steht:

- XX für die Gesamtschirmung:

- U = ungeschirmt

- F = Folienschirm

- S = Geflechtschirm

- SF = Geflecht- und Folienschirm

- Y steht für die Aderpaarschirmung:

- U = ungeschirmt

- F = Folienschirm

- S = Geflechtschirm

Ausführungen[Bearbeiten | Quelltext bearbeiten]

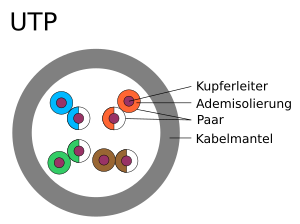

UTP[Bearbeiten | Quelltext bearbeiten]

Neue Bezeichnung nach ISO/IEC 11801 (2002)E: U/UTP

Kabel mit ungeschirmten Paaren und ohne Gesamtschirm (Unshielded Twisted Pair). Im deutschsprachigen Raum werden UTP-Kabel kaum eingesetzt, weltweit sind es jedoch die meistverwendeten Kabel für Ethernet-LANs (> 90%). Für Übertragungsverfahren bis Gigabit-Ethernet reicht ein UTP-Kabel der Kategorie 5e aus. Erst für zukünftige Techniken werden geschirmte Kabel benötigt (10-Gigabit-Ethernet), aber auch hier wird es einen Standard geben, der mit UTP-Kabeln funktioniert – allerdings mit der Einschränkung, dass nur geringere Reichweiten möglich sein werden. Im Gespräch sind bis zu 50 m auf UTP-Kabeln gegenüber 90 m auf STP-Kabeln.

Bis zur Kategorie 6 ist ein UTP-Kabel wegen seines geringen Außendurchmessers und der fehlenden Schirme einfach zu verarbeiten und in der Regel preisgünstiger als STP-Kabeltypen. Dem entgegen steht jedoch, dass gegenüber stromführenden Komponenten und Kabeln deutlich höhere Abstände eingehalten werden müssen, als das bei geschirmten Kabeln notwendig wäre.

Ab Kategorie 6A (10-Gigabit-Ethernet) werden in UTP-Kabeln künstlich Asymmetrien aufgebaut, um Alien-Next-Problematiken bei parallel geführten Leitern entgegenzuwirken. Bedingt durch diesen Umstand ist der Außendurchmesser gestiegen und in der Regel sogar größer als bei SF/FTP-Kabeln der Kategorie 7 und höher.

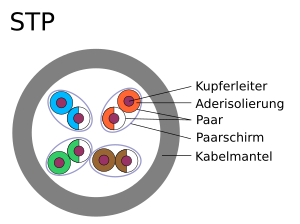

STP[Bearbeiten | Quelltext bearbeiten]

Kabel mit Schirmung (Shielded Twisted Pair) in unterschiedlichen Varianten:

S/STP = screened shielded twisted pair (mit einem Paarschirm als Drahtgeflecht und einem Gesamtschirm als Drahtgeflecht)

F/STP = foiled shielded twisted pair (mit einem Paarschirm als Drahtgeflecht und einem Gesamtschirm als Folie)

FTP[Bearbeiten | Quelltext bearbeiten]

Neue Bezeichnung nach ISO/IEC-11801 (2002)E: U/FTP

Die Adernpaare sind mit einem metallischen Schirm (meist eine aluminiumkaschierte Kunststofffolie) umgeben (Foiled Twisted Pair). Bei Schirmung jeweils eines Paares spricht man auch von PiMF (Paar in Metallfolie), umfasst der Schirm zwei Paare, so wird das auch als ViMF (Vierer in Metallfolie) bezeichnet. Die aktuelle Version der EN50173–1 bezeichnet diese Kabel mit FTP. Bis zur Kategorie 6 galt typischerweise, dass durch diese zusätzliche Schirmung das FTP-Kabel einen geringfügig größeren Außendurchmesser als UTP-Kabel hatte und etwas größere Biegeradien aufwies. (Siehe Hinweise ab Kategorie 6A bei UTP-Kabeln). Jedoch sind FTP-Kabel hinsichtlich Alien Next-Effekten und gegenüber Querdruck in der Regel unempfindlicher und effizienter als UTP-Kabel. Das Übersprechen zwischen den einzelnen Adernpaaren kann durch die Schirmung ebenfalls verringert werden (siehe auch Elektromagnetische Verträglichkeit).

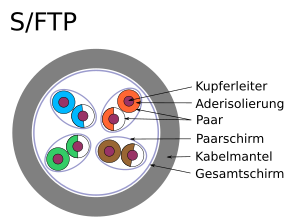

S/FTP, F/FTP oder SF/FTP[Bearbeiten | Quelltext bearbeiten]

Neue Bezeichnung nach ISO/IEC-11801 (2002)E: S/FTP (Geflecht), F/FTP (Folie), SF/FTP (Geflecht+Folie)

Aufbau wie bei FTP, jedoch mit zusätzlicher metallischer Gesamtschirmung um die Leiterbündel (Screened Foiled Twisted Pair). Der Gesamtschirm kann als Folie oder als Drahtgeflecht oder aus beidem zusammen ausgeführt sein. Gemäß aktueller EN50173 werden diese Kabel mit einem F für einen Folienschirm bezeichnet, ein S steht für einen Kupfergeflechtschirm, ein SF steht für einen Gesamtschirm aus Folie und Geflecht. Der Bedeckungsgrad des Geflechts sollte über 30% liegen, um gegenüber niederfrequenten Feldern eine hinreichende Abschirmung zu erzielen.

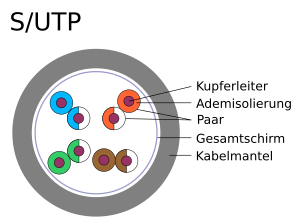

S/UTP, F/UTP oder SF/UTP[Bearbeiten | Quelltext bearbeiten]

Neue Bezeichnung nach ISO/IEC-11801 (2002)E: S/UTP (Geflecht), F/UTP (Folie), SF/UTP (Geflecht+Folie)

Aufbau wie bei UTP, jedoch mit zusätzlicher metallischen Schirmung um die Leiterbündel (Screened Unshielded Twisted Pair). Der Gesamtschirm kann als Folie oder als Drahtgeflecht oder aus beidem zusammen ausgeführt sein. Gemäß aktueller EN50173 werden diese Kabel mit einem F für einen Folienschirm bezeichnet, ein S steht für einen Kupfergeflechtschirm, ein SF steht für einen Gesamtschirm aus Folie und Geflecht.

Gründe für Schirmung[Bearbeiten | Quelltext bearbeiten]

durch die schirmung werden folgende effekte deutlich verringert:

- NEXT

- beeinflussung durch ein anderes adernpaar des selben kabels auf der senderseite

- FEXT

- beeinflussung durch ein anderes adernpaar des selben kabels auf der empfängerseite

Senderseite Empfängerseite

Signal A → ========================== → Signal A - Dämpfungsverluste

|| | | | : :

VV V V v v v

NEXT(A) ← ========================== → FEXT(A)

- alien crosstalk

- beeinflussung durch ein anderes paralell geführtes kabel

Lichtwellenleiter (Dispersion)[Bearbeiten | Quelltext bearbeiten]

Aufbau und Funktionsweise[Bearbeiten | Quelltext bearbeiten]

Glasfaserkabel bestehen aus einer oder mehreren hochtransparenten Glasfasern, geschützt durch einen Kunststoffmantel, der wenige Millimeter dick ist. Erdkabel sind evtl. zusätzlich verstärkt (z.B. mit einem Metallgeflecht gegen Tierbiss).

Eine Glasfaser (meist aus reinstem Kieselglas, chemisch Siliciumdioxid) besteht aus einem Kern (engl. core), einem Mantel (engl. cladding) und einer Schutzbeschichtung (engl. coating und/oder buffer). Der lichtführende Kern dient zum Übertragen des Signals. Der Mantel hat eine niedrigere optische Brechzahl (Dichte) als der Kern und bewirkt dadurch eine Totalreflexion an der Grenzschicht und somit eine Führung der Strahlung im Kern des Lichtwellenleiters. Dennoch tritt ein Teil der Lichtwelle auch im Mantel auf, nicht jedoch an dessen Außenoberfläche.

Bei Unterschreitung des minimalen Biegeradius der Glasfaser findet am Cladding keine Totalreflexion mehr statt, und ein Teil des Lichtes entweicht aus dem Glaskern. Dies macht sich in Form einer Dämpfungserhöhung bemerkbar und kann je nach Leistungsbudget, Streckenlänge und Biegung zum Totalausfall der Übertragung führen.

Speziell getrieben durch die hohen Anforderungen der Signalstärke und -qualität im Bereich FttH (Fiber to the Home) und den in Wohnhäusern schlechteren Installationsbedingungen entwickelten Glasfaserhersteller wie Corning, Draka, OFS etc. in der jüngsten Zeit neue Glasfasern, die um den Faserkern noch zusätzlich eine hochreflektierende Fluoridschicht oder ein auf Nanostruktur basierendes Cladding aufweisen.

Durch diese neuartigen biegeunempfindlicheren Fasern ist es möglich, auch bei Biegeradien, die im Bereich von unter 10 mm liegen, eine nahezu verlustlose Übertragung sicherzustellen. Diese neuartigen Fasertypen werden die bisherigen Fasertypen sowohl im Multimodebereich als auch im Singlemodebereich zukünftig weitgehendst ersetzen und sind spezifiziert nach z. B. ITU-T G.652C und D.

Die äußere Beschichtung ist ein Schutz vor mechanischen Beschädigungen und besteht meist aus einer 150–500 µm dicken Lackierung aus speziellem Kunststoff (meist Polyimid, Acryl oder Silicon), die die Faser auch vor Feuchtigkeit schützt. Ohne die Beschichtung würden die auf der Faseroberfläche vorhandenen Mikrorisse zu einer erheblichen Verringerung der mechanischen Belastbarkeit führen.

kurz[Bearbeiten | Quelltext bearbeiten]

- im kern glas hohe dichte

- drum herum (mantel) glas mit weniger hoher dichte

- dadurch totalreflexion (so wie wenn man aus der luft flach aufs wasser schaut, da sieht man nicht ins wasser weil alle lichtstrahlen die auf einen zukommen würden total reflektiert werden)

- totalreflexion nur bis zu einem grenzwinkel

- dadurch ergibt sich ein maximaler biegeradius von ca 5cm im verlegezustand

- wenn zu eng gebogen tritt ein teil des lichtstrahls in den mantel aus

Arten[Bearbeiten | Quelltext bearbeiten]

- single mode

- kerndurchmesser

- ausßendurchmesser

- Stufenindex

- apprupter übergang vom core zum mantel

- multi mode

- kerndurchmesser

- ausßendurchmesser

- gradientenindex

- "schleifender" übergang vom core zum mantel

besonderheiten im umgang mit glasfaserkabeln[Bearbeiten | Quelltext bearbeiten]

können nur sehr schlecht im nachhinein (außerhalb der fabrik) verbunden oder mit neuem stecker versehen werden, da beim verbinden von zwei kabeln leicht eine ungenauigkeit bei der deckung der kerne entstehen kann und der lichtstrahl an dieser stelle in den mantel verlohren geht

Dispersion[Bearbeiten | Quelltext bearbeiten]

http://de.wikipedia.org/wiki/Chromatische_Dispersion

Dispersion ist in der Optik die Abhängigkeit der Ausbreitungsgeschwindigkeit von Wellen von ihrer Wellenlänge λ. Insbesondere in Glasfasern laufen Signale verschiedener Farben daher auseinander. Dies wird als chromatische Dispersion bezeichnet.

Die Brechzahl eines Mediums ist abhängig von der Wellenlänge des Lichts. Kurzwellige Farben haben in der Regel eine größere Brechzahl als längerwellige. Die Ausbreitungsgeschwindigkeit des Lichts ist abhängig von der Brechzahl und kurze Lichtpulse haben notwendigerweise eine gewisse spektrale Breite. Daher führt die Weiterleitung solcher Pulse in einem dispersiven Medium im Allgemeinen zu einer Verbreiterung der Pulse. Die Signalform wird verwaschen und dadurch die Übertragungsrate begrenzt.

Die chromatische Dispersion wirkt bei einer Übertragungsrate von 10 Gbit/s in Glasfasern ab 25 km deutlich störend. Zwar gibt es Glasfasern aus speziell strukturierten Materialien, zum Beispiel die „Dispersion Shifted Fiber (DSF)“, die auf geringe chromatische Dispersion im dritten optischen Fenster bei 1550 nm optimiert ist, oder die „Non-Zero Dispersion Shifted Fiber (NZ-DSF)“. Trotzdem muss aber die chromatische Dispersion zusätzlich aktiv kompensiert werden, wenn bei Bitraten von 2,5 bis 40 GBit/s große Übertragungslängen erreicht werden sollen.

Was ist ein TOR-Switch?[Bearbeiten | Quelltext bearbeiten]

TOR[Bearbeiten | Quelltext bearbeiten]

Ein (oder mehrere, normalerweise zwei) Top Of Rack-Switch befindet sich ganz oben im rack und ist ausschließlich für die server im racks zuständig. Die Verbindungen zwischen dem TOR Switch und den Servern erfolgt durch RJ45 Patchkabel (1G) oder Fibre/CX4 10G. Die Verbindungen zwischen dem Access Switch (TOR Switch) und dem Aggregation Layer Switch erfolgt via Fiber Uplinks.

Anmerkung: ToR bezeichnet eigentlich nur eine topologische Ordnung der Verkabelung. Wo sich das Switch befindet, ist irrelevant (zb auch mitte möglich). Wichtig ist, das es nur für die Server im Rack zuständig ist und dann weiter zur Backbone verbunden wird.

Vorteile von TOR:

- Verkabelung (meist Kupfer) und Kabelmanagement innerhalb vom Rack vergleichsweise trivial

- Kosten für Verkabelung geringer

- Wartung eines TOR-Switches beeinträchtigt nur ein Rack, nicht die ganze Row

Nachteile von TOR:

- die port-auslastung ist teilweise schlecht wenn das rack nicht voll ist.

- der TOR-switch muss mindestens so schnell sein wie die anbindung des schnellsten servers (unter umständen aufrüstung wegen eines einzigen servers notwendig)

- Sehr viele Switches nötig, was in einem Datacenter üblicher Größe (20+ Racks pro Floor) schnell problematisch werden kann. Beispiel: 40 Racks, zwei Switches pro Rack (Redundanz), ergibt 80 Switches allein für die Serveranbindungen. Diese 80 Switches müssen einzeln verwaltet werden. Ein Austauschswitch muss korrekt konfiguriert werden, was meist geschultes Personal erfordert.

Alternative End of Row[Bearbeiten | Quelltext bearbeiten]

Mehrere Server-Racks stehen nebeneinander und bilden eine Row. Am Anfang der Reihe (oder am Ende, oder auch beides) steht ein Rack mit Netzwerkequipment. Jedes Serverrack hat ein oder mehrere Patchfelder, an denen die Server angeschlossen werden. Von jedem Patchfeld/Rack gehen (riesige) Kabelbünde zum Rack mit dem Netzwerkequipment, klassischerweise über Kabeltrassen an der Decke oder durch einen doppelten Boden. Oft sind so viele Kabel im Spiel, dass ein zusätzliches, eigenes Patching-Rack benötigt wird. Die Verkabelung erfolgt per Kupferkabel (Twisted Pair, RJ45).

Ein EOR-Switch ist normalerweise modular (á la Blade-Chassis) aufgebaut und enthält diverse Einschübe und Verwaltungseinheiten, sowie redundante Netzteile, Lüfter, etc.

Vorteile von EOR:

- Weit weniger Switches werden benötigt. Im Beispiel mit 40 Racks, angeordnet in 4 Rows zu 10 Racks, mit zwei EOR-Switches pro Row, sind das lediglich 8 Switches, die verwaltet werden müssen, nicht 80 wie im TOR-Design.

- Die verwendeten Switches sind langlebiger, höher verfügbar, einfacher (zentraler) zu verwalten und einfacher zu warten. Einschübe können ohne manuelle Neukonfiguration getauscht werden, auch von weniger geschultem Personal.

Nachteile von EOR:

- Enorm komplexe und schwierige Verkabelung. Hunderte Kupferkabel müssen über lange Wegstrecken verlegt werden.

- Kabelmanagement fast unmöglich

- Kupferkabel wiegen sehr viel im Vergleich zu LWL

- Eigene Ressourcen und Infrastruktur für das Patching nötig

- Ein EOR-Switch wird schnell zum Single Point of Failure und Wartung oder Probleme an einem EOR-Switch beeinträchtigen eine ganze Row

- Upgrade der Verkabelung von 1G-Ethernet zu 10G-, 40G- oder gar 100G-Ethernet wesentlich schwieriger, da alle Kabel getauscht werden müssten.

- Ein Upgrade des EOR-Switches auf neuere Ethernetvarianten hingegen ist leicht möglich, indem ein oder mehrere Einschübe upgegradet werden.

Interessanter Artikel zum Thema: https://web.archive.org/web/20180817155458/http://bradhedlund.com/2009/04/05/top-of-rack-vs-end-of-row-data-center-designs/ (aber Vorsicht, ist von Cisco).

Möglichkeit zum Sparen von Energie durch Gigabit-Switch?[Bearbeiten | Quelltext bearbeiten]

Frage ist nicht ganz klar..., aber gibt mehrere möglichkeiten

- Energiesparen für ungenutzte Ports

- Auf ungenutzten Ports liegt nur eine minimale Spannung (Standby-Modus) an. Diese reicht aus, um zu erkennen, ob an dem Interface ein anderes Gerät hängt. Erst dann wird mehr Energie geliefert.

- Cable Diagnostic

- Über die Funktion Cable Diagnostic erkennt das Gerät zudem die Länge des angeschlossenen Kabels und passt den Energiebedarf dementsprechend an. Nach Angaben eines Herstellers lassen sich dadurch bis zu 44 Prozent Energie einsparen. Die Performance soll davon nicht beeinträchtigt werden. Kompatibilität wird nicht eingebüßt.

Fragen die in Vorlesungen genannt wurden[Bearbeiten | Quelltext bearbeiten]

Die Kabel-Rechnenaufgabe[Bearbeiten | Quelltext bearbeiten]

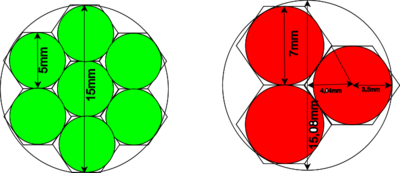

angenommen wir haben ein ungeschirmtes kabel mit 5mm durchmesser und ein geschirmtes kabel mit 7mm durchmesser. es gibt einen voll gefüllten wanddurchbruch mit d mm der momentan N ungeschirmte kabel führt. die ungeschirmten sollen durch geschirmte kabel ersetzt werden. wieviele neue löcher sind notwendig?

Kurz und (wohl zu) knapp[Bearbeiten | Quelltext bearbeiten]

- der durchmesser steigt um 40%

- die querschnittsfläche des kables also um 96%

- also ein neues loch weil fast doppelt so viel platz

Den rechnerischen Ansatz (siehe unten) habe ich bei der Prüfung genau so durchexerziert und war damit 100% erfolgreich. Wichtig ist, die Vorgehensweise erklären zu können. Die obige kurze und knappe Methode sollte aber auch passen.

Gegenbeispiel[Bearbeiten | Quelltext bearbeiten]

Anm.: die Überlegungen, die hier folgen, sind IMHO nicht auf die Aufgabenstellung anwendbar. Wirklich korrekt ist auf jeden Fall der rechnerische Ansatz unten.

- vorher 19 pro durchbruch

- nachher 8 pro durchbruch

- weiteres problem wird sichtbar, in diesem fall ist dichte packung der kabel nicht opmitimal (wie dann brechnen?)

- grund: es wird nur die fläche pro kabel, nicht die "schlichtabfallfläche" am rand berücksichtigt

- FALSCH der extremfall ist glaub ich vorher 3 nachher 1 pro loch. in dem fall würde es von 2 neue löcher mit steigender löchgröße langsam gegen 1 neues loch konvertieren. und ich glaube es konvergiert so langsam, dass es in der realität immer 2 neue löcher sind.

Worst case (glaub ich)[Bearbeiten | Quelltext bearbeiten]

rechnung:

- gleichseitiges dreieck, höhe bekannt

- formel:

- umgeformt

- minimaldurchmesser für 3 kabel á 7mm

da können wir nur 2 kabel á 7mm durch ein loch tun. folglich brauchen wir 3 neue löcher!

Rechnerischer Ansatz[Bearbeiten | Quelltext bearbeiten]

- Gegeben

- Kreisrunder Wanddurchbruch mit Durchmesser führt ungeschirmte Kabel mit Durchmesser . Der Durchbruch ist mit den 5mm-Kabel komplett ausgefüllt. Diese 5mm-Kabel sollen komplett durch geschirmte Kabel mit ersetzt werden.

- Gesucht

- Wie viele weitere Wanddurchbrüche sind nötig, um die neuen Kabel verlegen zu können?

- Vereinfachende Annahmen

- Packungsdichte ist optimal, sprich Kabel lassen sich ohne Verluste an Nutzquerschnittfläche nebeneinander verlegen und etwaige Verluste am Rand werden ignoriert. Das bedeutet, dass die Summe der Querschnittflächen der 5mm-Kabel genau die Querschnittfläche des Wanddurchbruchs ergibt.

- Anmerkung

- Das Ergebnis dieser Rechenaufgabe hängt klarerweise von den Durchmessern und ab. Bei etwa benötigt man mehr zusätzliche Löcher, als mit .

Querschnittfläche des Wanddurchbruchs berechnet sich durch , also gilt

.

Die Querschnittfläche eines 5mm-Kabels ist nach der selben Formel:

Die Querschnittfläche eines 7mm-Kabels ist demnach:

Da die 5mm-Kabel bzw. die 7mm-Kabel die Querschnittfläche des Wanddurchbruchs komplett ausfüllen, gilt, entsprechend den vereinfachenden Annahmen von oben:

wobei die Anzahl von 7mm-Kabeln ist, die durch den Wanddurchbruch passen. Das ist ein Gleichungssystem von zwei Gleichungen in drei Unbekannten (, und ), daher so nicht lösbar. Einfach lösbar wäre es, wenn der konkrete Durchmesser des Wanddurchbruchs gegeben wäre.

Allerdings kann man, entsprechend der Idee von ganz oben, mit Verhältnissen rechnen. Dazu formt man das Gleichungssystem etwas um und kann und als Verhältnisse von einander ausdrücken:

Das bedeutet, im gegebenen Wanddurchbruch lassen sich an 7mm-Kabeln etwas mehr als die Hälfte der ursprünglichen 5mm-Kabel unterbringen. Man wird also einen weiteren Wanddurchbruch benötigen.

Um ein anschauliches Ergebnis zu bekommen, wählt man willkürlich einen Durchmesser des Wanddurchbruchs, etwa , dann lassen sich , und einfach berechnen:

.

Daraus folgt (auf ganze Zahlen gerundet):

Man benötigt also ein weiteres Loch um alle 900 Kabel von Durchmesser unterzubringen.