TU Wien:Verteilte Systeme VO (Göschka)/Fragenkatalog Wiki

Achtung: Änderung der Prüfungsmodalitäten und Gültigkeit dieses Fragenkatalogs[Bearbeiten | Quelltext bearbeiten]

Laut LVA-Homepage [1] gibt es nur mehr einen Prüfungstermin (14.10. 2013), für den auch wirklich Fragen aus diesem Katalog gestellt werden. Ab dann gilt folgendes für die Prüfungen:

- The only one exam of this course is the final written one. There is no midterm exam.

- An exam will consist of 20 questions. Unlike previous semesters, these questions are NOT in any public question catalog. The exam will take 80 minutes. It is a closed book exam.

- Exam questions will be based on the topics of the lectures given in the course. The exam preparation materials will be the lecture notes and corresponding chapters/sections of text books/papers/articles mentioned in the lectures.

- There will be no questions for topics in the text books which are not covered in the lectures or for topics which are not required as home exercises.

- Exam questions will cover both concepts/techniques in the course as well as how to apply these concepts/techniques.

- There will be 2 questions for each lecture (in total 20 questions for 10 lectures)

- An answer for a question will be given:

- 0 point if the answer is incorrect,

- 0.5 point if the answer is half-correct (40%-70% of the answer is correct and the answer shows a clear path that it leads to a complete correct answer)

- 1 point if the answer is correct

- The maximum number of points of an exam is 20. The following mapping is applied

- 18- 20 points = 1 (sehr gut) (100-90 % of the maximum number of points)

- 16 - 17.5 points = 2 (gut) (89 - 80 % of the maximum number of points)

- 13 - 15.5 points = 3 (befriedigend) (79-64 % of the maximum number of points)

- 10.5 - 12.5 points = 4 (genügend) (63-51 % of the maximum number of points)

- 0-10 points = 5 (nicht genügend) (50-0 % of the maximum number of points)

Da der Fragenkatalog große Teile des Stoffs abdeckt, ist es sicher nicht schlecht, wenn man ihn als Lernhilfe hernimmt, allerdings wird es nicht so wie bisher sein, dass garantiert Fragen daraus gestellt werden. Weiters sei angemerkt, dass der Fragenkatalog durchaus nicht vollständig ist und auch Fehler enthält. Wenn du einen entdeckst, bessere ihn bitte aus, am besten mit Quellenangabe (z.B. Buchseite).

Versionen[Bearbeiten | Quelltext bearbeiten]

Stand 1.1.2011: Alle Fragen sind am letzten Stand und entsprechen nun dem aktuellen Fragekatalog auf der VO-Seite: [2]

Dies ist der ausgearbeitete Fragenkatalog aus dem Wintersemester 07/08 für Verteilte Systeme. Vieles der Informationen wurde aus einem Google-Docs-Dokument, das leider nicht mehr weiter verbessert werden kann (da die AutorInnen das Interesse an dem Dokument verloren haben...), heraus kopiert. Es gibt zu dem Google-Docs Dokument auch einen Thread im Informatik-Forum. Es wurden nun auch aktuelle Themen aus dem WS 08/09 eingearbeitet. Im WS09/10 wurden alte Fragen gekennzeichnet, teilweise erweitert und formatiert.

Grundlagen und Konzepte[Bearbeiten | Quelltext bearbeiten]

- Buch: Kap. 1 und 2 bis inkl. 2.2

Definition Verteiltes System[Bearbeiten | Quelltext bearbeiten]

Frage: Geben Sie eine charakterisierende Definition für ein "Verteiltes System" an. Nennen Sie die wichtigsten Design-Ziele bzw. charakteristischen Eigenschaften von Verteilten Systemen. Stellen Sie weiters den Zusammenhang zu den typischen Fallstricken beim Entwurf verteilter Systeme her.

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Definition Verteiltes System\s*/si}}

- Definition

- Ein Verteiltes System ist eine Menge voneinander unabhängiger Computer, die dem Benutzer wie ein einzelnes, kohärentes System erscheinen.

Eigenschaften:

- Ein Verteiltes System besteht aus autonomen Komponenten.

- Den Benutzern (Menschen oder Programmen) präsentiert es sich als ein einziges System.

- Unterschiede zwischen den einzelnen Computern und der Art wie sie miteinander kommunizieren bleiben weitgehend vor den Benutzern verborgen. Ebenso der innere Aufbau.

- Benutzer können konsistent und einheitlich mit dem System arbeiten.

- Grundsätzlich sollten Verteilte Systeme einfach zu erweitern oder zu skalieren sein.

- Es steht normalerweise ununterbrochen zur Verfügung, auch wenn einige Komponenten vorübergehend ausfallen.

Um heterogene Computer und Netzwerke zu unterstützen und gleichzeitig das Erscheinungsbild eines einzigen Systems anzubieten, werden Verteilte Systeme häufig mit Hilfe einer Softwareschicht angeordnet, welche sich logisch zwischen einer Höheren Ebene von Benutzern und Anwendungen und einer darunter liegenden Ebene von Betriebssystemen und grundlegenden Kommunikationseinrichtungen befindet. Entsprechend wird ein solches Verteiltes System als 'Middleware' bezeichnet. Selbstverständlich unterscheiden sich verteilte Systeme von herkömmlicher Software, weil die Komponenten über ein Netz verteilt sind. Diese Verteilung während des Entwurfs nicht zu berücksichtigen macht viele Systeme unnötig komplex und führt zu Fehlern die später oft behoben werden müssen. Folgende typischen Fehlannahmen werden beim Entwurf verteilter Systeme oft getroffen:

- Das Netzwerk ist zuverlässig.

- Das Netzwerk ist sicher.

- Das Netzwerk ist homogen.

- Die Topologie ändert sich nicht.

- Die Latenzzeit beträgt Null.

- Die Bandbreite ist unbegrenzt.

- Die Übertragungskosten betragen Null.

- Es gibt genau einen Administrator.

Designziele eines Verteilten Systems:

- Ressourcen sollen leicht zugänglich sein

- Soll verstecken, dass Ressourcen im Netzwerk verteilt werden (=Transparenz)

- Openness

- Soll skalierbar sein

- Fehlertoleranz

- Concurrency

Was ist Transparenz?[Bearbeiten | Quelltext bearbeiten]

Frage: Was ist Transparenz? Beschreiben Sie die standardisierten Arten von Transparenz und erklären Sie den Zusammenhang zwischen den einzelnen Transparenz-Definitionen. Was ist der Nachteil von Transparenz?

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Was ist Transpar.*\s*/si}}

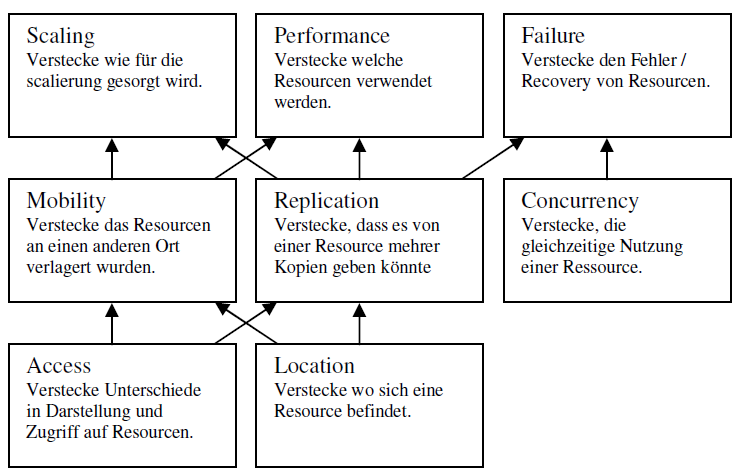

Transparenz: Die Verteilung des Systems soll vom Benutzer verborgen werden (ein VS, das für den User wie ein einziger Computer aussieht, nennt man transparent).

- Access:Hide differences in data representation and how a resource is accessed

- Location: Hide where a resource is located

- Migration: Hide that a resource may be moved to another location

- Relocation: Hide that a resource may move to another location while in use

- Replication: Hide that a resource may exist in several copies

- Concurrency: Hide that a resource may be shared by several competitive users

- Failure: Hide the failure and recovery of a resource

- Persistence:Hide whether a (software) resource is in memory or on disk

Frage:

- Wo genau ist der Unterschied zu Skalierungs- u. Leistungstransparenz?

- Zusammenhang

- Siehe Grafik in Folie 1 - Seite 39 (fälschlicherweise bezeichnet als Seite 41).

- Nachteile

- Es gibt Situationen (wenn sich verteilte Systeme auf Geräte erstrecken, die von Menschen herumgetragen werden), in denen Orts- und Kontextkenntnis von Bedeutung sind. z.B.: ist es besser ein Dokument auf dem beschäftigten Drucker im Nachbarzimmer auszudrucken, als auf einem freien Drucker, der sich aber in einem anderen Land befindet.

- Vollständige Verteilungstransparenz ist nicht möglich -> Benutzer verstehen das Verhalten eines VTs besser, wenn sie wissen, dass es so etwas wie Transparenz nicht gibt.

- Es gibt Situationen in denen es keine gute Idee ist, alle Aspekte der Verteiltheit vor dem Benutzer komplett zu verbergen.

- Trade-Off zwischen einem hohen Grad an Transparenz und der Performance des Systems! (z.B. wenn Replikas auf verschiedenen Kontinenten immer konsistent sein müssen, kann eine einzelne Update-Operation Sekunden dauern, was vor dem Benutzer nicht mehr verborgen werden kann; Maskierung des Ausfalls eines Servers kann System auch verlangsamen).

- Was Embedded und Ubiquitous VS betrifft, kann es besser sein, die Verteiltheit offen darzustellen, anstatt sie verbergen zu wollen.

- Angesichts der Tatsache, dass vollständige Verteilungstransparenz nicht möglich ist, ist fraglich, ob es überhaupt vernünftig ist, dies vorzugeben – wird die Verteilung explizit gemacht, so wird das (manchmal unerwartete) Verhalten eines VS verständlicher.

Was versteht man unter "Openness"?[Bearbeiten | Quelltext bearbeiten]

Frage: Was versteht man unter "Openness"?

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Was versteht man unter "Openness"?\s*/si}}

Ein "Offenes VS" bietet Dienste nach Standardregeln an, die die Syntax und die Semantik dieser Dienste beschreiben.

In VS werden Dienste generell durch Schnittstellen (Interfaces) spezifiziert, die oft in einer Interface Definition Language (IDL) beschrieben sind.

Gute Spezifikationen sind vollständig (alles, was für eine Implementierung erforderlich ist, wurde spezifiziert) und neutral (Spezifikationen schreiben nicht vor, wie eine Implementierung aussehen soll).

Vollständigkeit ist wichtig für Interoperabilität (beschreibt den Grad bis zu dem zwei Implementierungen von Systemen/Komponenten verschiedener Hersteller zusammenarbeiten können, indem sie sich lediglich auf die Dienste der anderen verlassen, die nach einem gemeinsamen Standard spezifiziert sind).

Neutralität ist wichtig für Portabilität (beschreibt, in welchem Ausmaß eine Anwendung, die für VS A entwickelt wurde, ohne Veränderungen auf VS B ausgeführt werden kann, das dieselben Schnittstellen wie A implementiert).

Ein offenes VS sollte auch erweiterbar sein (Hinzufügen/Ersetzen von Komponenten, ohne dass die vorhandenen beeinträchtigt werden) -> Flexibilität

Um in einem offenen VS Flexibilität zu erzielen, sollte es aus kleinen, einfach austauschbaren/anpassbaren Komponenten angeordnet sein -> impliziert, dass nicht nur Definitionen der Schnittstellen der obersten Ebene (die von Benutzern/Anwendungen gesehen werden), sondern auch für Schnittstellen zu den internen Bestandteilen des Systems bereitgestellt werden sollten, und außerdem beschrieben wird, wie diese Bestandteile zusammenarbeiten.

Nötig ist Trennung von Policy (Richtlinie) und Mechanismus!

Eine Definition: Offenheit (Openness): Ein verteiltes System ist ein offenes verteiltes System, wenn neue Dienste zu den bereits existierenden Diensten hinzugefügt werden können, ohne letztere zu Unterbrechen bzw. Dienste zu duplizieren

Scalability[Bearbeiten | Quelltext bearbeiten]

Frage: Erläutern Sie Probleme und Lösungsansätze für "Scalability".

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Scalability\s*/si}}

Scalability ist die Fähigkeit des Systems bei wachsenden Anforderungen noch einsatzfähig zu sein. Die Skalierbarkeit eines Systems kann dabei in mindestens drei unterschiedlichen Dimensionen gemessen werden:

- Größe/Ausmaß: noch mehr Benutzer oder Ressourcen können einfach hinzugefügt werden

- Geographisch: die Benutzer und Ressourcen dürfen weit auseinander liegen (topologisch)

- Administrativ: noch immer einfach verwaltbar, auch wenn es sich über viele unabhängige administrative Organisationen (domains) erstreckt.

Probleme bei der Skalierbarkeit (meist Performance-Probleme)

- Größe:

Werden mehrere Benutzer oder Ressourcen unterstützt, werden wir häufig mit den Einschränkungen zentralisierter Dienste, Daten und Algorithmen konfrontiert:- Zentrale Services, z.B. ein einziger Server für alle Benutzer (ist aber oft für die Sicherheit erforderlich!)

- Zentral verwaltete Daten, z.B. ein einziges Online-Telefonbuch

- Zentral ablaufende Algorithmen, z.B. Routing durchzuführen, das auf vollständiger Information basiert

- Nur dezentrale Algorithmen sollten verwendet werden! Charakteristika dezentraler Algorithmen:

- Keine Maschine hat vollständige Information über den Systemstatus.

- Computer entscheiden nur auf Grund von lokalen Informationen.

- Der Ausfall eines Computers schädigt nicht den Algorithmus.

- Die Existenz einer globalen Uhr wird nicht implizit vorausgesetzt.

- Geographisch:

- Verteilte Systeme die für LANs entwickelt wurden, basieren auf synchroner Kommunikation: Client blockiert bis Antwort zurück gesendet wird – problematisch in WANs (zu langsam)

- Kommunikation in WANs ist inhärent unzuverlässig und so gut wie immer Point-to-Point, LANs hingegen bieten hoch zuverlässige Kommunikation und unterstützen Broadcasting

- Geographische Skalierbarkeit hängt stark mit den Problemen zentralisierter Lösungen zusammen, die auch die Größenskalierbarkeit behindern.

- Administrativ:

Schwierige Frage wie ein verteiltes System über mehrere voneinander unabhängige administrative Domänen skaliert werden kann. Ein Problem sind die widersprüchliche Strategien zur- Benutzung (und Bezahlung) von Ressourcen

- Verwaltung

- Sicherheit

Skalierungstechniken:

- Verbergen der Latenzzeiten (wichtig für geographische Skalierbarkeit)

- asynchrone Kommunikation -> Abarbeiten von anderen Aufgaben, während man auf eine Antwort wartet.

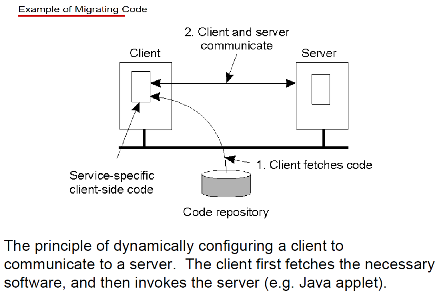

- Gesamte Kommunikation reduzieren (z.B. Teile der Berechnung zum Client-Prozess verschieben, wie z.B. Überprüfen von Formulareinträgen schon beim Client)

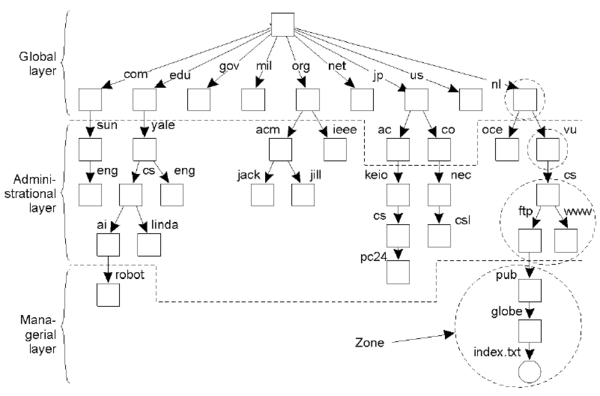

- Verteilung -> Komponenten in kleinere Teile zerlegen und über gesamtes System verteilen. Bsp.: DNS (hierarchisch in Domains organisiert -> dieser wiederum in sich nicht überschneidende Zonen aufgeteilt -> Namen in jeder Zone werden von einem einzigen Name-Server behandelt)

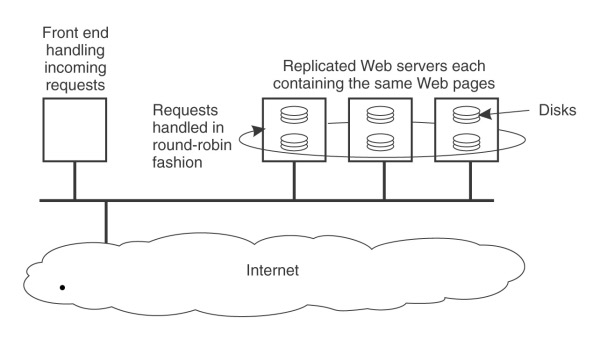

- Replikation

- Erhöht Verfügbarkeit

- Balanciert die Last zwischen Komponenten aus -> bessere Performance

- In WANs kann eine nahe gelegene Kopie Kommunikations-Latenz-Probleme verbergen

- Caching = spezielle Form der Replikation (vom Client ausgelöst)

- Nachteil: Caching und Replikation führt zu Konsistenzproblemen!

Probleme bei Scalable Size:

- Controlling the cost of physical resources: The quantity required should be O(n)

- Controlling the performance loss: In hierarchical system should be no worse than O(log n)

- Preventing software resources running out, but over-compensation may be even worse: Internet Addresses or Oracle7 2TB restriction

- Avoiding performance bottlenecks (centralized services, data, or algorithms)

Vertikale Verteilung[Bearbeiten | Quelltext bearbeiten]

Frage: Was versteht man unter der vertikalen Verteilung bzw. N-Schichten-Systemen? Diskutieren Sie dabei alle Grundvarianten von Client/Server-Systemen. Ist folglich ein Java Applet eher ein Thick Client oder ein Thin Client?

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Vertikale Verteilung\s*/si}}

Das charakteristische Merkmal einer vertikalen Verteilung ist, dass sie erzielt wird, indem logisch unterschiedliche Komponenten auf (physisch) unterschiedlichen Maschinen angeordnet werden.

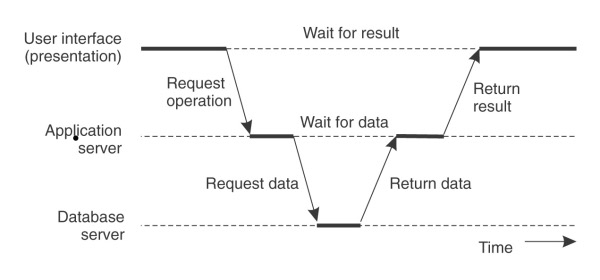

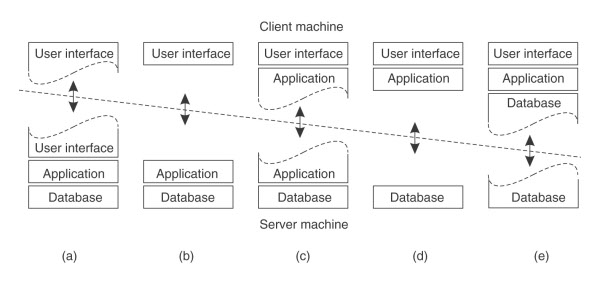

Das Client/Server Modell wird grundsätzlich in 3 verschiedene Anwendungsschichten unterteilt:

- Die Ebene der Benutzeroberfläche enthält alles, was erforderlich ist um direkt mit dem Benutzer zu interagieren. Bsp.: Verwaltung der Bildschirmdarstellung

- Die Verarbeitungsebene (Business Logic)

- hier wird die Kernfunktionalität programmiert. (enthält Anwendungen)

- Die Datenebene

- hier werden die Daten unabhängig von der Applikation persistent gespeichert

Bei einer Unterscheidung von Client- und Serverseite spricht man von einer two-tier Architektur. Folgende Aufteilungen sind dabei denkbar:

- (a) Nur ein Teil des UI liegt auf der Clientseite, z.B. ein Terminal.

- (b) Der client-seitige Prozess stellt das gesamte User Interface dar, alles andere wird vom Server übertragen.

- (c) Teile der Applikation werden zum Client verlagert, z.B. für einfache Operationen wie das Überprüfen der Korrektheit von Daten, bevor sie zum Server geschickt werden.

- (d) Der Server wird nur als Persistenzschicht verwendet. Applikationen laufen am Client und führen nur Operationen auf Files oder Datenbanken am Server durch.

- (e) Teile der Daten liegen auch beim Client, z.B. Caches.

Bei (a) und (b) spricht man von Thin Clients, bei (d) und (e) von Fat Clients.

Wenn die 3 Anwendungsschichten auf 3 verschiedenen Maschinen ansäßig sind, liegt eine three-tier Architektur vor, wie es z.B. bei vielen Websites der Fall ist: Der Web Server agiert nur als Entry Point einer Seite und leitet die Anfrage weiter an einen Application Server, welcher wiederum einen Datenbankserver aufruft.

Ein Java Applet ist irgendwo in der Nähe von (c/d) anzusiedeln, was es eher zu einem Fat Client macht. (User Interface und Application werden am Client ausgeführt)

Horizontale Verteilung[Bearbeiten | Quelltext bearbeiten]

Frage: Was ist horizontale Verteilung? Mit welchen grundlegenden Design-Fragen müssen Sie sich beim Entwurf der horizontalen Verteilung eines Systems beschäftigen? Gibt es einen Zusammenhang zur vertikalen Verteilung?

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Horizontale Verteilung\s*/si}}

Bei der horizontalen Verteilung können ein Client oder ein Server physisch in logisch äquivalente Teile unterteilt werden, aber jeder Teil arbeitet mit einem eigenen Anteil der vollständigen Datenmenge, sodass die Gesamtlast ausgeglichen ist.

=> "Anteil der vollständigen Datenmenge" => wirkt hier etwas verwirrend. Jeder Teil operiert auf der gleichen, vollständigen Datenmenge und nicht nur auf einem Teil davon. by thex

- Wie sicher ist das? Zitat Buch Seite 44 "[..] but each part is operating on its own share of the complete dataset [..]" Ich hätte das wie im ursprünglichen Satz hier interpretiert --emptyvi

Ich denke hier darf nicht von einer Datenbank die repliziert wird ausgegangen werden, sondern z.B. eher von einer Gruppe (Cluster) von Webservern. Dabei arbeitet jeder von ihnen mit einem Anteil (die vom LoadBalancer ihm zugeteilten HTTP Requests) der vollständigen Datenmenge (alle HTTP Requests) --Mannaz 19:08, 9. Mär. 2011 (CET)

Die horizontale Verteilung von Anwendungskomponenten lässt also auch eine Zerlegung der Anwendungskomponenten auf physisch getrennte Rechner zu. Während bei der vertikalen Verteilung Anwendungskomponente genau einem Rechner zugeordnet werden. Wichtiger Bestandteil solcher Systeme ist eine geeignete Middleware,um verteilte Komponenten bzw. Objekte zu einem kohärenten Ganzen zusammen zu führen (z.B. CORBA, Enterprise JavaBeans, etc.) (???)

Beim Entwurf einer horizontalen Verteilung sollte man sich auch Gedanken machen welches Konsistenzmodell gewählt wird um sicherzustellen, dass die Server alle mit den gleichen Datenelementen arbeiten.

Datenzentrierte Konsistenzmodelle (strenge-, sequezielle-, kausale-, FIFO-Konsistenz) versus Clientzentrierte Konsistenzmodelle (Eventuelle Konsistenz, Monotones Lesen, etc)

(mein gedanke dazu)

Designfrage:

- Werden Replikate erst bei Bedarf erstellt oder schon am Anfang

- Weitergabe der Aufgaben vom Handler durch Round-Robin oder durch Aufgabenspezifische Unterteilung (aufgabenspez. Verteilung würde man doch bei vertikaler Verteilung nehmen oder? Wenn ich mich an die Laborübung erinnere war eine Round-Robin Alternative, dass mehrere Replikas nach Zufallsprinzip ausgewählt wurden,

Mit den Designfragen könnte auch das gemeint sein(deckt sich ungefähr mit den Folien S.62):

- Komponenten die oft kommunizieren sollten nahe beieinander liegen

- Physische Einschränkungen: einige Komponenten können nur auf spezifischen Rechnern oder an speziellen Orten laufen

- Granularität: Kleinere Komponenten erhoehen die Flexibilitaet, aber ebenso den Netzwerkverkehr. Umgekehrt reduzieren größere Komponenten die Netzwerkbelastung, aber ebenso wird die Flexibilitaet und Wiederverwendbarkeit reduziert.

- Wahl der Protokolle: entscheidend für Interoperabilität und Last

- End to End Eigenschaften: CAP - Consistency, Availability, Performance

- Full distribution -> distributed architecture

Was ich weis kann man das eben wählen ob Round Robin oder Aufgaben spezifisch, ist eben eine Design-Frage)

Horizontale Verteilung kann mit der vertikalen Verteilung kombiniert werden.

Beispiel zur horizontalen Verteilung (Webserver): Jeder Server verwaltet dieselbe Menge an Webseiten, und immer wenn eine Webseite aktualisiert wird, wird eine Kopie davon auf jeden Server platziert (je nach Konsistenzmodell verschieden schnell). Trifft eine Anforderung ein, wird sie unter Verwendung einer Round-Robin-Strategie an einen Server weitergegeben. Genügend Bandbreite vorausgesetzt, ist diese Form der horizontalen Verteilung sehr effektiv.

TODO: Zusammenhang mit der vertikalen Verteilung

Communication (1) - Middleware und RPC[Bearbeiten | Quelltext bearbeiten]

- Buch: 2.1 (w.h.), 2.3, 2.4, 4.1, 4.2

ISO-OSI Modell[Bearbeiten | Quelltext bearbeiten]

Frage: Beschreiben Sie das ISO-OSI Modell der geschichteten Protokolle (Grundprinzip). Stellen Sie den Bezug zu den Internet-Protokollen (TCP/IP) her. Warum sind Transport-Layer Protokolle für Verteilte Systeme oft nicht ausreichend?

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*ISO-OSI Modell\s*/si}}

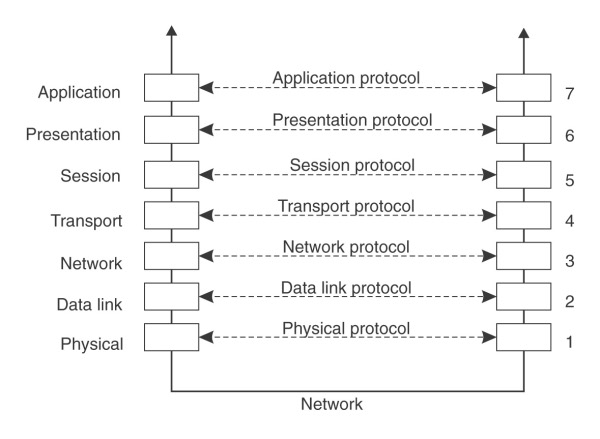

Auf Grund des Fehlens von Shared Memory basiert die gesamte Kommunikation in verteilten Systemen auf dem Senden und Empfangen von Nachrichten (auf der untersten Ebene). Wenn ein Prozess mit einem entfernten Prozess kommunizieren möchte sind Vereinbarungen auf einer Vielzahl von Schichten erforderlich, von den Details der Bitübertragung auf unterster Ebene bis hin zu den Einzelheiten auf höherer Ebene, wie Informationen auszudrücken sind. Für einen einfacheren Umgang mit den mit der Kommunikation verbundenen Schichten hat die International Organization for Standardization (ISO) ein Referenzmodell entworfen, das die verschiedenen beteiligten Schichten klar herausstellt und benennt.

Das OSI-Modell (Open Systems Interconnection Reference Model) wurde entwickelt, um offenen Systemen die Kommunikation zu ermöglichen. Offenes System: ist dazu bereit, mit jedem anderen offenen System zu kommunizieren – durch die Verwendung von Standard-Regeln, die Format, Inhalt und Bedeutung der gesendeten und empfangenen Nachrichten regeln/bestimmen. Diese Regeln sind in Protokollen formalisiert. Zwei generelle Arten von Protokollen:

Verbindungsorientiert: bevor Daten ausgetauscht werden, richten Sender und Empfänger explizit eine Verbindung ein und verhandeln eventuell über das Protokoll, das sie verwenden werden. Wenn sie fertig sind müssen sie die Verbindung lösen/beenden (z.B. Telefonanruf). circuit switched (?) -> Verlässlichkeit vs. Setup-Aufwand

Verbindungslos: Kein Setup im Vorhinein notwendig, der Sender verschickt einfach die erste Nachricht wenn sie fertig ist. (z.B. Brief in Briefkasten werfen. packet switched (?)

Im OSI-Modell wird die Kommunikation auf sieben Schichten bzw. Ebenen (Layer) aufgeteilt. Jede Schicht behandelt einen bestimmten Aspekt der Kommunikation. Auf diese Weise wird das Problem in Teile zerlegt und unabhängig voneinander auf verschiedenen Ebenen gelöst. Jede Schicht bietet eine Schnittstelle zur darüberliegenden Schicht.

Wenn Prozess A auf Maschine 1 mit Prozess B auf Maschine 2 kommunizieren will, erstellt er eine Nachricht und gibt sie an den Application Layer seiner Maschine weiter. Der Application Layer fügt der Nachricht vorne einen Header hinzu und gibt sie über das Layer 6/7-Interface an den Presentation Layer weiter etc… Der Data-Link Layer fügt zusätzlich hinten einen Trailer hinzu. Der Physical Layer übermittelt schließlich die Nachricht, indem er sie an das physische Übertragungsmedium übergibt.

Beim Empfänger geht die Nachricht den umgekehrten Weg (wird nach oben übermittelt), wobei jede Schicht seinen eigenen Header überprüft, und kommt schließlich beim Prozess B an. Die Information im Layer n -Header wird für das Layer n -Protokoll verwendet.

Jede Schicht hat bei diesem Modell ihr eigenes Protokoll, das unabhängig von anderen ausgetauscht werden kann. Die Ansammlung der in einem bestimmten System verwendeten Protokolle wird Protokollsuite bzw. Protokollstack genannt. Die OSI Protokolle waren niemals beliebt, dagegen werden die für das Internet entwickelten Protokolle wie TCP und IP am häufigsten verwendet.

- Physical Layer (Bitübertragung)

Die Bitübertragungsschicht ist für das Übertragen der Einsen und Nullen zuständig. Das Protokoll der Bitübertragungsschicht kümmert sich um die Standardisierung der Elektrischen-, Mechanischen- und Signalschnittstellen, sodass eine von einem Rechner ausgesendete 1 auch tatsächlich als 1 und nicht als 0 empfangen wird. Die Bitübertragungsschicht sendet lediglich Bits. Hierbei können allerdings Fehler auftreten, sodass ein Verfahren benötigt wird, um sie zu entdecken und zu korrigieren. - Data Link Layer (Sicherung)

Dies ist Aufgabe der Sicherungsschicht. Sie gruppiert die Bits in Frames und berechnet eine Prüfsumme. Der Empfänger berechnet die Prüfsumme erneut. Stimmen beide überein wird der Frame als korrekt anerkannt und angenommen, wenn nicht bittet der Sender den Empfänger um die erneute Übertragung. - Network Layer (Vermittlung)

Damit eine Nachricht vom Sender zum Empfänger gelangen kann können (in WANs) mehrere Teilstrecken (Hops) erforderlich sein. Die Auswahl des besten Weges (Routing) ist Aufgabe des Network Layer. Momentan ist das am weitesten verbreitete Netzwerkprotokoll das verbindungslose Internetet Protocol (IP) - Transport Layer (Transport)

Die Transportschicht bildet den letzten Teil des grundlegenden Netzwerkprotokollstacks. Die Anwendungsschicht kann somit eine Nachricht an die Transportschicht in der Erwartung übermitteln, dass sie ohne Verluste ihr Ziel erreicht. Wenn die Transportschicht eine Nachricht von der Anwendungsschicht erhält, zerteilt sie sie in kleine Stücke (die klein genug für eine Übertragung sind) weist jedem eine fortlaufende Nummer zu und sendet dann alle. Transportverbindeungen können auf verbindungslosen oder verbindungsorienierten Netzwerkdiensten aufsetzten. Bei verbindungslosen Diensten kann nicht garantiert werden, dass alle Pakete in der selben Reihenfolge ankommen, in der sie gesendet wurden. Es ist Aufgabe der Software der Transportschicht, alles wieder in die richtige Reihenfolge zu bringen. Das Transportprotokoll des Internets wird TCP (Transmission Control Protocol) genannet. Die Kombination TCP/IP ist heute der Standard für Netzwerkkommunikation. Die Internetprotokollsuite unterstützt auch ein verbindungsloses Transportprotokoll namens UDP (Universal Datagram Protocol).

Vorhandene Transportprotokolle sind oft nicht ausreichend, so werden regelmäßig neue vorgeschlagen, wie beispielsweise RTP (real-time transport protocol) zur Datenübertragung in Echtzeit. - Session Layer (Sitzung)

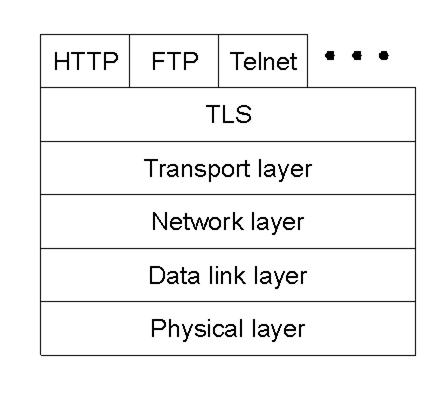

Die Sitzungsschicht ist im Wesentlichen eine erweiterte Version der Transportschicht. Sie bietet eine Dialogkontrolle, um zu verfolgen welcher Teilnehmer gerade spricht, sowie Funktionen zur Synchronisierung. In der Praxis sind nur wenige Anwendungen an der Sitzungsschicht interessiert. In der Internetprotokollsuite ist sie nicht vorhanden. - Presentation Layer (Darstellung)

Die Darstellungsschicht beschäftigt sich mit der Bedeutung der Bits. Hier können spezielle Konvertierungen stattfinden. Im Internet ist hier das SSL Protokoll angesiedelt. - Application Layer (Anwendung)

Die Anwendungsschicht verschafft Anwnendungen Zugriff auf das Netzwerk. Der eigentliche Anwendungsprozess liegt darüber und ist nicht im OSI Modell abgebildet.

* * Bsp.: File Transfer Protokoll (FTP): Übertragung von Dateien zwischen Client und Server (nicht mit dem Programm FTP zu verwechseln!)

* Hyper Text Transfer Protokoll (HTTP): Übertragung von Webseiten

Im OSI Modell fehlt eine klare Unterscheidung zwischen Anwendungen, anwendungsspezifischen Protokollen und Protokollen für allgemeine Zwecke.

Anmerkung: Von den drei Schichten oberhalb der Transportschicht wird in der Praxis nur die Anwendungsschicht genutzt. Die Internet-Protokollsuite fasst alles oberhalb der Transportschicht zusammen. (Wird es wirklich zusammengefasst? ich dachte es ist bei der IP Suite einfach nicht implementiert) (steht zumindest so im Buch: S.121 "In fact, in the Internet protocol suite, everything above the transport layer is grouped together." aber ich denke auch, dass zumindest die Funktionalität des session layers in der Internet-Protokollsuite nicht implementiert ist, deshalb wäre ich dafür den satz einfach wieder zu streichen - was meint ihr????)

Mein Senf dazu: Es wird auch der Presentation Layer (#6) für SSL Encryption genutzt, siehe Kapitel Security. Somit ist im Internet nur der Session Layer (#5) unbenutzt.

Gegenüberstellung TCP/IP und OSI siehe Grafik (link kaputt, weiß wer was da war?)

Warum sind Transport Layer Protokolle für verteilte Systeme oft nicht ausreichend?

Die Tranport-Layer Protokolle sind fuer verteilt Systeme oft nicht ausreichend, da sie die geforderten Transparenzen oft nicht erfüllen.

Es sind weitere Protokolle notwendig um z.B. Location Transparency, Concurrency Transparency, ... zu erreichen.

Was ist Middleware[Bearbeiten | Quelltext bearbeiten]

Frage: Was ist Middleware? Welche Anforderungen stellt man an Middleware? Welche Services soll Middleware bieten? Erläutern Sie den Zusammenhang zwischen Middleware und Architectural styles.

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Was ist Middleware\s*/si}}

Middleware ist eine Softwarekomponente die viele oft von Verteilten Systemen benötigte Services zusammenfasst und in parametrisierbarer Form anbietet. Man muss daher gleiche Funktionalitäten nicht immer neu implementieren. Die Schicht ist logisch zwischen Application- und Transportlayer einzuordnen. Services von Middleware sind z.B. Verschlüsselung, Authentifizierung, Security, Replikation, Access-Transparenz, Naming etc. Man kann annehmen, dass sich die Entwicklung von Middleware für Verteilte Systeme weitgehend mit der Behandlung zusätzlicher Funktionalität unabhängig von Anwendungen beschäftigt. Die Middleware bildet eine Schicht zwischen Anwendungen und verteilten Plattformen. Ein wichtiger Zweck besteht darin einen Grad von Verteilungstransparenz zu bieten, der in einem gewissen Maß die Verteilung von Daten, die Verarbeitung und die Steuerung vor den Anwendungen verbirgt. Wenn Middleware nach einem bestimmten Architekturstil geformt ist, hat das den Vorteil, dass der Entwurf von Anwendungen einfacher werden kann, eventuell ist die Middleware dann jedoch nicht mehr optimal für das geeignet was der Anwendungsentwickler im Sinn hat.

Important styles of architecture for distributed systems (Folien)

- Layered architectures (OSI)

- Object-based architectures (and components)

- Data-centered architectures (file based, database, resourceful WS, ...)

- Event-based architectures

- .... and combinations thereof

Anforderungen: (ich glaube das ist eher gefragt als die Anforderungen unten)

- Unterstützt Transparenz

- Unterstützt Offenheit

- Unterstützt Wartbarkeit

- Unterstützt Interface Definition

- Gibt die Möglichkeit Skalierbarkeit hinein zu bringen

- Life-cycle Management für die Komponenten (aktivieren/deaktivieren)

- Liefert Kommunikationsgrundlagen

- Liefert Unterstützung für Concurrency (Thread library)

Services:

- Kommunikationsservice für Zugriffstransparenz

- Naming

- Persistence Service für die Persistence Transparenz

- Verteilte Transaktionen

- Replikationen um Failure Transparenz zu unterstützen

- Securitymechanismen: Authentication, Authorisation

Anforderungen an Middleware: Middleware ist nicht immer ideal für die Anwendungen, die Applikationsentwickler im Sinn hatten: CORBA hat z.B. nur Objekte bereitgestellt, die von remote clients aufgerufen werden konnten. Es hat sich herausgestellt, dass nur diese Form der Interaktion zu einschränkend ist. Also wurde Messaging hinzugefügt. Das hinzufügen von Features kann aber zu einer aufgeblasenen Middleware führen. Und obwohl Middleware Verteilungstransparenz bereitstellen sollte, sollten bestimmte Lösungen auch an die Applikationsanforderungen anpassbar sein. Eine Lösung wäre, unterschiedliche Middleware-Versionen zu entwerfen. Eine andere Möglichkeit ist Middlewaresysteme leicht konfigurierbar und adaptierbar zu gestalten.

Flexibilität[Bearbeiten | Quelltext bearbeiten]

Frage: Wie kann man die Flexibilität der Middleware erhöhen sowie die Zusammenarbeit von Middleware und Anwendung effizienter gestalten? Erläutern Sie dabei die Grundprinzipien von Interceptoren, Adaptivität und Self-Management.

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Flexibilität\s*/si}}

Flexibilität der MW erhöhen:

- Interceptors

- Separation of concern (Modularisierung)

- Reflection (Anpassen der Parameter zur Laufzeit)

- Component-based design

- Middleware-Application interaction (Plug-ins, ...)

- Autonomic computing, self-* (Selbstregulierung, Selbstwiederherstellung, ...)

Ein wichtiger Zweck von Middleware (Schicht zwischen Applikationen und verteilten Plattformen) ist es, einen gewissen Grad an Verteilungstransparenz zu bieten.

Auch Middleware-Systeme folgen bestimmtem Architekturstil (z.B. Object-based (CORBA, Event-based (TIB/Rendezvous))

Middleware-Systeme sollen einfach konfigurierbar, adaptierbar und individuell anpasspar sein, je nach Applikation daher wird Trennung zwischen Policy und Mechanismus vorgenommen!

TODO /* bzg. effizientere Gestaltung würde ich meinen, dass hier eine bessere Anpassbarkeit (eventuell automatisch) Bezug genommen werden kann (seite 58 / 59 Discussion bietet da glaub ich eine gute Richtlinie für die Beantwortung)

- Interceptors

Software-Konstrukte, die den normalen Kontrollfluss unterbrechen und es erlauben, anderen (Applikations-spezifischen) Code auszuführen = Mittel um die Middleware anzupassen Objekt A ruft eine Methode auf, die zu Objekt B gehört, welches sich auf einer anderen Maschine als Obj. A befindet. Das ist ein Remote Object Call, dieser erfolgt in drei Schritten:

- A und B bieten beide das gleiche Interface an. A ruft die Methode auf, die in diesem Interface verfügbar ist auf.

- Der Aufruf von A wird in eine "generic object invocation" transformiert, möglich gemacht durch ein "object-invocation interface" der Middleware der Maschine, auf der sich A befindet.

- Am Schluss wird die "gen. obj. invoc." in eine message transformiert und wird über das transport-level network interface geschickt, das A's local operating system anbietet.

- Generelle Ansätze zu Adaptiver Software

Middleware soll sich an Veränderungen in der Umgebung eines DS anpassen –> Konstruktion adaptiver Software. Drei Basistechniken, um zu Software-Adaptierung zu kommen:

- Separation of concerns: Traditionelle Art, Systeme zu modularisieren (d.h. Trennen der Teile eines Systems, die Funktionalität implementieren, von denen, die für Extrafunktionalitäten wie Reliability, Performance, Security etc. zuständig sind.) – ist in DS nicht einfach (Thema für aspect-oriented software development)

- Computational reflection: Fähigkeit eines Programms, sich selbst zu überprüfen und, wenn notwendig, sein Verhalten anzupassen

- Component-based design: unterstützt Anpassung durch Komposition (dynamisch zur Laufzeit)

- Self-Management in Verteilten Systemen

Selbstmanagement ist in großen, verteilten Systemen von entscheidender Bedeutung. Für viele Systeme stellen eine zentrale Verwaltung und Organisation keine optimale Lösung dar. Die meisten selbstverwaltenden Systeme haben gemeinsam, dass Anpassungen mithilfe einer oder mehrerer Rückkopplungsschleifen (feedback-control-loops) erfolgen. Diese Schleife besteht neben den Komponenten, die das eigentliche VS ausmachen, aus 3 Teilen:

- Die metric estimation component quantifiziert die Aspekte eines Systems, die Rückschlüsse auf seine Effizienz zulassen, z.B. Latenzzeiten.

- Die feedback analysis component wertet diese Messungen aus und bestimmt, welche Veränderungen am System vorgenommen werden.

- Schließlich beeinflussen verschiedene Anpassungsmechanismen das System direkt und verändern z.B. die Platzierung von Repliken, Scheduling Strategien oder Lastverteilung

Remote Procedure Call[Bearbeiten | Quelltext bearbeiten]

Frage: Erläutern Sie das Grundprinzip des Remote Procedure Call. Gehen Sie auf die Begriffe "client stub" und "server stub" näher ein.

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Remote Procedure Call\s*/si}}

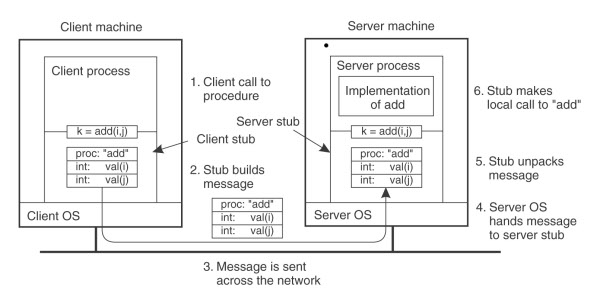

Programme erhalten die Möglichkeit Prozeduren auf entfernten Rechnern auszuführen. Wenn ein Prozess auf Rechner A eine Prozedur auf dem Rechner B aufruft, wird der Prozess auf A angehalten und die Ausführung der aufgerufenen Prozedur findet auf Rechner B statt. Die Parameter können Informationen vom Aufrufer zum Aufgerufenen übertragen und werden im Ergebnis der Prozedur zurückkommen.

- Der Client-Stub (auf dem Rechner des Clients) kapselt den entfernten Aufruf. Für den Aufrufer sieht der Aufruf also lokal aus. Erst durch den Client-Stub erfolgt die Weiterleitung des Aufrufs an den Server

- Der Server-Stub auf dem Server kapselt die eigentliche Prozedur, die aufgerufen wird. Der Server-Stub nimmt den entfernten Aufruf an. Für die Server-Prozedur sieht der Aufruf so aus als käme er von einem lokalen Programm

A client stub is responsible for conversion of parameters used in a function call and deconversion of results passed from the server after execution of the function.

A server stub , is responsible for deconversion of parameters passed by the client and conversion of the results after the execution of the function.

Um einen RPC kurz zusammen zu fassen, sollen folgende Dinge erwähnt sein (Ablauf eines RPCs OHNE das Marshaling zu erwähnen):

- die Client Proc ruft den Client Stub auf

- der Client Stub baut sich an Hand der Parameter die Message und gibt diese dem OS

- das OS versendet diese Message an das OS des Remote Rechners

- das OS des Remote Rechners nimmt die Message entgegen und gibt sie dem Server Stub

- dieser packt die Parameter aus und ruft dann (lokal) den Server auf

- ... (Weg retour mit Return-Parametern) ...

Variablen-Handling bei (Remote) Procedure Calls[Bearbeiten | Quelltext bearbeiten]

Frage: Wie können Variablen bei Prozedur-Aufrufen grundsätzlich übergeben werden? Wie werden Sie bei RPC gehandhabt und welche Probleme gibt es dabei? Was versteht man in diesem Zusammenhang unter "parameter marshalling"?

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Variablen-Handling bei \(Remote\) Procedure Calls\s*/si}}

Grundsätzlich können Variablen auf folgende Weisen übergeben werden:

- Call by value = der Wert der Variable wird übergeben

- Call by reference = der Pointer der auf die Variable am lokalen Rechner zeigt wird übergeben

- Call by copy/restore = der Wert der Variable wird kopiert und nachdem der aufgerufene Prozess fertig ist, wird die orginale Variable überschrieben.

Bei RPC kann man alle drei Varianten verwenden wobei man bei folgenden Punkten aufpassen muss:

- bei call-by-reference hat man das Problem dass eine lokale Adresse auf einen anderen Rechner sinnfrei ist. Also muss man diesen aufruf durch copy/restore ersetzen.

- bei den anderen beiden Arten hat man das Problem dass auf dem anderen Rechner sehr wahrscheinlich nicht genau die gleiche Darstellung von Zeichen, Zahlen usw wie auf dem lokalen Rechner vorherrscht. Man muss also vorher die Daten in ein Format bringen die der andere Rechner versteht. Dieser Prozess nennt sich marshalling.

Wenn die Parameter in ihrer marshalling Darstellung beim anderen Rechner ankommen, kann dieser sie interpretieren und den Aufruf der Prozedur mit den korrekten Daten aufrufen.

[eventuell Remove? glaub alle fragen wurden über dem Bild schon beantwortet]

Die Variablen, auch Parameter genannt, werden in Nachrichten verpackt und an den Server Stub gesendet. Das Verpacken von Parametern in Nachrichten wird auch als Marshaling bezeichnet.

(EDIT by Hochi ich glaub hier ist eher gemeint: call-by-value,call-by-reference,copy restore wenn nicht löschen)

In großen verteilten Systemen kommt es häufig vor, dass unterschiedliche Maschinen verwendet werden. Dabei kann es vorkommen das die unterschiedlichen Maschinen eigene Darstellungen für Zahlen, Zeichen und andere Datensätze verwenden (IBM Mainframe verwendet den EBCDIC-Zeichencode - IBM PC´s verwenden den ASCII Zeichensatz, Intel verwendet Little endian - SPARC verwendet Big endian, etc.)

- EDIT -

Meiner Meinung nach bezieht sich diese Frage auch auf den Abschnitt 4.2.2 Parameter Passing aus dem Buch, wo explizit auf Passing Value Parameters und Passing Reference Parameters eingegangen wird. Dazu gehört dann noch die ganze Sache mit dem Marshaling.

Passing Reference Parameters gestaltet sich dabei als durchaus schwierig, da eine Referenz am Client nicht gleich der Referenz am Server ist. (Beide arbeiten ja in einem eigenen Adressraum). Deshalb gibt es hierfür zB folgenden Ansatz: am Client-Stub wird die Referenz "aufgelöst", indem der gesamte Inhalt des zB Arrays mit in die Message kopiert wird. Am Server kann dann auf dieser Kopie gearbeitet werden. Wenn der Server nun fertig ist, wird die gesamte Message wieder retour übertragen und der Client stellt mittles copy/restore das Array bei sich wieder her. Dies ist nicht unbedingt performant, schafft aber Abhilfe gegen das Referenz Problem. Es gibt durchaus Optimierungen, wo zB durch vorheriges Wissen ob Parameter INPUT oder OUTPUT Parameter sind, eventuelle Kopien davon verworfen werden können bzw nicht mehr übertragen werden müssen.

Client/Server/IDL bei RPC[Bearbeiten | Quelltext bearbeiten]

Frage: Wie schreibt man für RPCs Client und Server und welche Rolle spielt dabei die IDL? Welche Ziele werden mit dem Einsatz einer IDL in einem verteilten System verfolgt? Was versteht man in diesem Zusammenhang unter "binding"?

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Client\/Server\/IDL bei RPC\s*/si}}

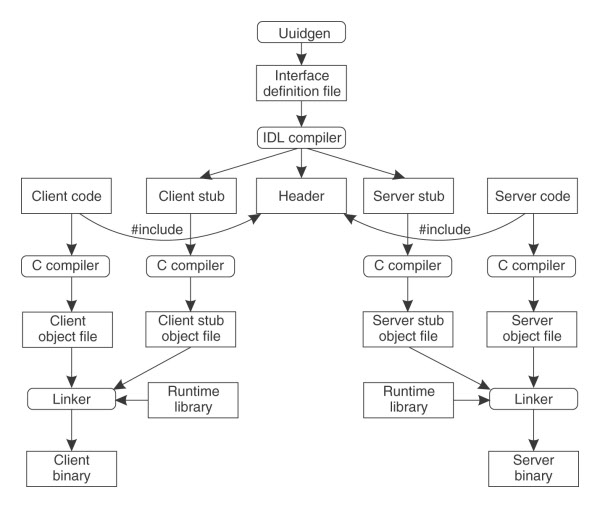

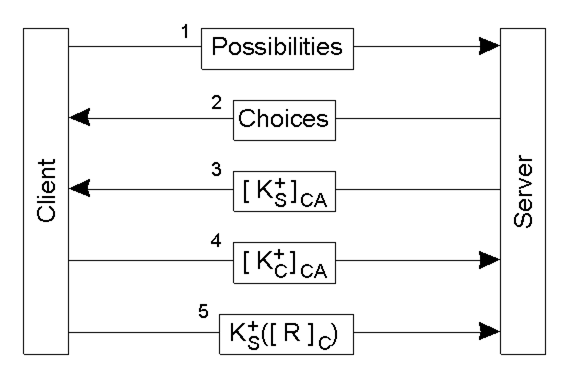

Der gesamte Prozess einen RPC-Client und Server zu schreiben und einzusetzen ist in nebenstehender Abblidung zusammengefasst.

In einem Client-Server-System ist die Schnittstellendefinition (angegeben in der IDL - Interface Definition Langugae) der Kleber, der alles zusammenhält. In den IDL-Datein sind Prozedurdeklarationen (in ähnlicher Form wie Funktionsprototypen in C), Typedefinitionen, Konstantendeklarationen und andere Infomationen für die korrekte Verpackung der Parameter und das Auspacken der Ereignisse enthalten.

Ein extrem wichtiges Element jeder IDL-Datei ist ein global eindeutiger Bezeichner für die spezifizierte Schnittstelle. Versucht ein Client versehentlich sich zu einem falschen Server zu binden, oder auch zu einer älteren Version des richtigen Servers, wird der Fehler erkannt und das Binden findet nicht statt.

Nachdem die IDL-Datei bearbeitet wurde (Namen der Prozeduren und ihre Parameter eingetragen) , wird der IDL Compiler aufgerufen.

Die Ausgabe des IDL-Compilers besteht aus drei Teilen:

- Header-Datei (wird jeweils in den Sever- und Client-Code inkludiert)

- Client-Stub

- Server-Stub

Anschießend werden der Client sowie der Server Code kompiliert, ebenso wie die beiden Stub-Prozeduren. Die resultirenden Client-Code- und Client-Stub-Objektdateien werden anschließend zu der Laufzeitbibliothek gebunden, um die ausführbare Programmdatei für den Client zu erzeugen. Analog dazu werden der Server-Code und der Server-Stub kompiliert und gebunden (EDIT: gelinkt ist vielleicht besser), um die Programmdatei des Servers zu erzeugen. Mit dem Einsatz der IDL als Schnittstellendefinitionssprache wird die Applikationsentwicklung wesentlich vereinfacht. Daher bieten alle RPC basierenden Middleware-Systeme eine IDL, bei manchen ist sie sogar zwingend vorgeschrieben.

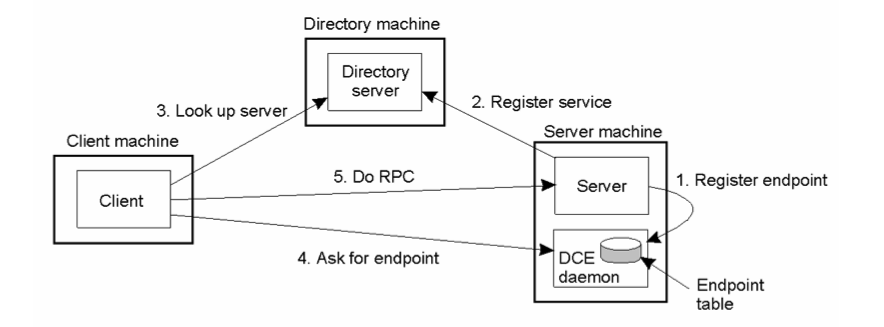

Binding bei RPC

Um eine fremde Prozedur aufzurufen, muss eine Nachricht vom Client-Prozess zum Server-Prozess versendet werden. In dieser müssen der Name der Prozedur (oder eine ID) und die zugehörigen Parameterwerte enthalten sein. Die Nachricht sollte letztlich bei einem Server-Prozess ankommen, der genau diese Prozedur implementiert.

Binding:

- Server registriert einen Endpoint

- Server registriert einen Service

- Client looks up the Service at a Directory Service

- Client asks Server for Endpoint

- Client sends RPC

Asynchrone RPC[Bearbeiten | Quelltext bearbeiten]

Frage: Welche Arten von asynchronen RPCs gibt es? Geben Sie auch einen verallgemeinerten Überblick über verschiedene Typen der Kommunikation (persistent/transient bzw. synchron/asynchron).

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Asynchrone RPC\s*/si}}

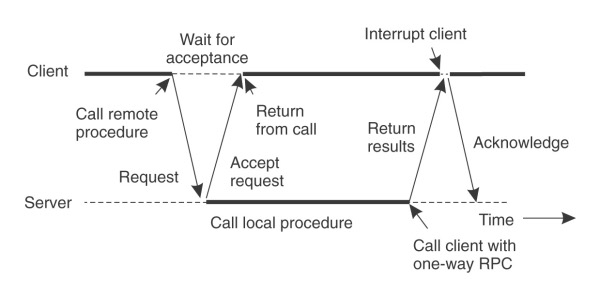

Grundsätzlich kann zwischen 3 Arten von RPCs unterschieden werden:

- synchron - Der Client wartet auf ein Ergebnis des RPCs.

- asynchron - Der Client wartet auf eine Empfangsbestätigung des RPCs.

- one-way - Der Client wartet nicht (nicht einmal auf eine Empfangsbestätigung).

Der verzögerte synchrone RPC besteht aus der Aneinanderreihung von 2 asynchronen RPCs:

- 1. asynchroner RPC (Anfrage) wird vom Client an den Server gesendet.

- 2. asynchroner RPC (Ergebnisse) wird vom Server an den Client gesendet.

somit ergeben die beiden asynchrone RPCs einen verzögerten synchronen RPC (es wird verzögert ein Ergebnis gesendet)

Warum in der Grafik der RPC als one-way gekennzeichnet wurde ist fraglich. Meine Vermutung wäre, dass der Server

trotzdem nicht untätig auf eine Empfangsbestätigung vom Client wartet sondern weitere Anfragen bearbeitet und die

Bestätigung optional bekommt.

- ein verzögerter RPC besteht aus einem RPC vom Client zum Server mit der Anfrage, und einem RPC vom Server zum Client mit der Antwort. Zweiterer ist ein Einweg-RPC. Das Zusammenführen der beiden Calls ist also quasi der "verzögerte-RPC" --thomas 18:13, 7. Mär. 2012 (CET)

Verzögerter synchroner RPC:

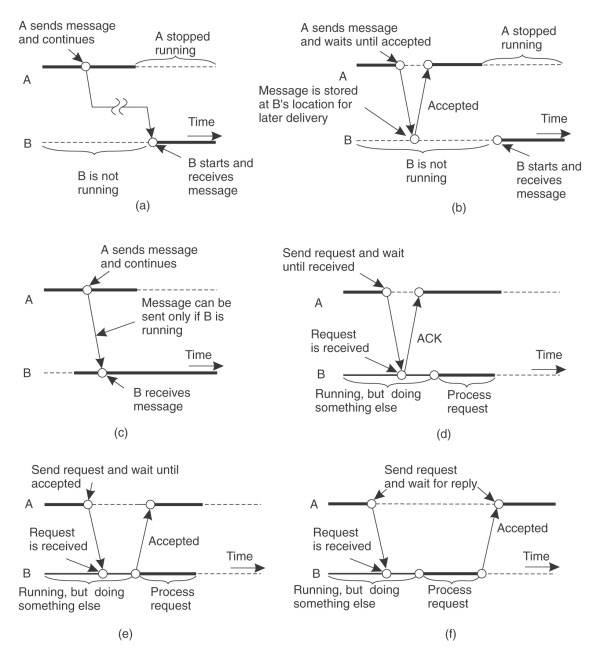

Allgemeiner Überblick über verschiedene Typen der Kommunikation (Kapitel Message-Oriented-Communication):

Achtung: Bedeutung von asynchron unterscheidet sich hier etwas von der Bedeutung bei RPCs.

(a) Persistente asynchrone Kommunikation; (b) Persistente synchrone Kommunikation; (c) Transiente asynchrone Kommunikation; (d) Empfangsbasierte transiente synchrone Kommunikation; (e) Auslieferungsbasierte transiente synchrone Kommunikation; (f) Antwortbasierte transiente synchrone Kommunikation

Bei einer persistenten Kommunikation wird eine zur Übertragung übergebene Nachricht so lange von der Kommunikations-Middleware gespeichert, wie es dauert, sie an den Empfänger auszuliefern. Im Gegensatz dazu wird bei transienter Kommunikation eine Nachricht nur so lange gespeichert, wie die sendende und empfangende Anwendung ausgeführt werden. Die charakteristische Eigenschaft asynchroner Kommunikation ist, dass der Sender sofort fortfährt, nachdem er seine Nachricht zur Übertragung abgegeben hat. Bei der synchronen Kommunikation ist der Sender gesperrt, bis er weiß, dass seine Anforderung akzeptiert wurde.

Communication (2) - RMI und Messaging[Bearbeiten | Quelltext bearbeiten]

- Buch: 4.3, 4.4, 10.1.1, 10.3, 10.4

Remote Object/Method Invocation[Bearbeiten | Quelltext bearbeiten]

Frage: Erläutern Sie die Grundprinzipien verteilter Objekte sowie der Remote Object (bzw. Method) Invocation. Gehen Sie auf die Begriffe "proxy" und "skeleton" ein. Erklären Sie den Unterschied zwischen "Compile-time" und "Run-time" Objekten. Erklären Sie den Unterschied zwischen persistenten und transienten Objekten.

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Remote Object\/Method Invocation\s*/si}}

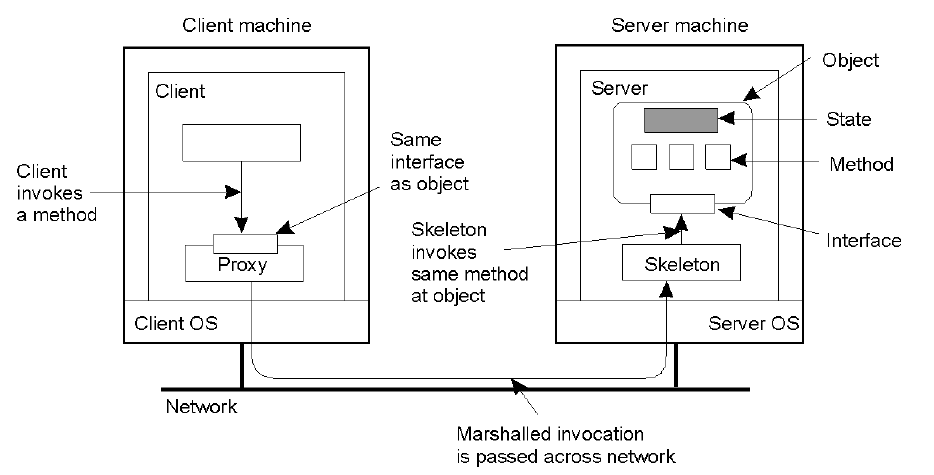

Die Schlüsselfunktion von Objekten ist die Kapselung von Daten, also den Zustand, und den Operationen auf diesen Daten, also den Methoden. Methoden sind durch ein Interface verfügbar. Es ist wichtig zu verstehen, dass es keinen "legalen" Weg für einen Prozess gibt um auf den Zustand eines Objekts zuzugreifen oder diesen zu verändern ausser durch den Aufruf von Methoden, die durch das Interface des Objekts angeboten werden. Ein Objekt implementiert eventuell mehrere Interfaces und ein Interface kann von mehreren Objekten implementiert werden.

Diese Aufteilung zwischen Interfaces und den Objekten, die sie implementierten ist essenziell für verteilte Systeme. Eine strikte Aufteilung erlaubt uns ein Interface auf einen Computer (Client) zu platzieren während das Objekt auf einem anderen Computer (Server) liegt. Diese Organisation, wie in der folgenden Abbildung gezeigt, wird verteiltes Objekt genannt. Siehe auch #Object / Distributed Object

Wenn sich der Client an das verteilte Objekt bindet, wird die Proxy (Client-Stub) Implementierung geladen. Diese übernimmt das Marshalling der Parameter und das Unmarshalling der Antwort.

Der Skeleton (Server-Stub) übernimmt das Parameterunmarshalling, das Ausführen des Methodenaufrufs des Objekts und Marshalling der Antwort am Server.

Compile Time Objekte basieren auf Klassendefinitionen (beschreibt einen abstrakten Datentyp). Diese Definition beinhaltet alle Methoden, die das Objekt aufweist und seine Struktur kann zur Laufzeit nicht geändert werden. Von einer kompilierten Klasse können dann zur Laufzeit die Objekte instanziert werden.

- Vorteil: Aus einer Klassendefinitionen können Client & Server Stubs abgeleitet werden (IDL)

- Nachteil: weniger flexibel als reine Laufzeitobjekte. Sprachabhängig. Genau eine Programmiersprache.

Laufzeitobjekte werden zur Laufzeit konstruiert. D.h. Die Implementierung ist weitgehend offen.

- Vorteil: verschiedene Programmiersprachen lassen sich leichter verbinden. Object wird mittels Object Adapter (wrapper) erstellt und somit sprachunabhängig gemacht.

- Nachteil: automatische Generierung von Stubs nicht möglich

Transiente Objekte existieren nur im (Arbeits-) Speicher des Servers, d.h. Wenn der Server beendet wird hört das Objekt auf zu existieren.

Persistente Objekte sind auf einen persistenten Speicher gesichert und können nach einem Neustart wieder von diesem gelesen werden.

Binding bei RMI[Bearbeiten | Quelltext bearbeiten]

Frage: Wie funktioniert das Binding bei RMI? Welchen Zusammenhang gibt es zu den verschiedenen Arten, eine object reference zu implementieren. Vergleichen Sie (exemplarisch) CORBA und Java in Bezug auf Objektreferenzen.

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Binding bei RMI\s*/si}}

Um eine fremde Prozedur aufzurufen, muss eine Nachricht vom Client-Prozess zum Server-Prozess versendet werden. In dieser müssen der Name der Prozedur (oder eine ID) und die zugehörigen Parameterwerte enthalten sein. Die Nachricht sollte letztlich bei einem Server-Prozess ankommen, der genau diese Prozedur implementiert.

Binding:

- Server registriert einen Endpoint

- Server registriert einen Service

- Client looks up the Service at a Directory Service

- Client asks Server for Endpoint

- Client sends RPC

Ich bin der Meinung, dass alles obig gesagte zu dieser Frage nicht richtig ist. Es wird das Binding bei RPC beschrieben, und nicht bei RMI. Einer der wesentlichen Unterschiede zwischen RPC und RMI ist ja, dass RPC einzelne Prozedur remote aufrufbar macht, RMI hingegen Methoden von Objekten (objektorientiert). Kurz: Beschrieben wird hier Binding bei RPC, gefragt ist aber Binding bei RMI.

Ich würde die ersten beiden Fragen so beantworten:

Ad "Wie funktioniert das Binding bei RMI":

Binding bei RMI kann entweder implizit oder explizit erfolgen[1]. Wird implizit gebunden, so wird der Client genau dann transparent an das Objekt gebunden, wenn die Referenz zum eigentlichen Objekt aufgelöst wird. Beim expliziten Binden muss hingegen erst eine bestimmte Funktion aufgerufen werden, um sich an das Objekt zu binden, ehe dessen Methoden aufgerufen werden können. (Beim Expliziten Binden wird normalerweise ein Pointer auf einen Proxy zurückgegeben, welcher dann lokal verfügbar ist. Binden führt dazu, dass im Addressraum des Prozesses am Client ein Proxy angelegt wird, der eine Schnittstelle mit Methoden enthält, die der Prozess aufrufen kann.[2]

Ad "Welchen Zusammenhang gibt es zu den verschiedenen Arten, eine object reference zu implementieren?":

Bei allen Arten muss ausreichend Information vorhanden sein, damit sich ein Client an ein bestimmtes Objekt binden kann. Eine einfach Implementierung könnte beispielsweise aus Netzwerkadresse des Rechners (auf dem das Objekt liegt) + Endpoint der Kommunikation (der den Server auf dem Rechner bezeichnet) (+ Hinweis auf das zu referenzierende Objekt) [2].

[1] Folien WS10/11 Nummer 20.

[2] Buch "Verteilte Systeme - Prinzipien und Paradigmen, Andrew S. Tanenbaum und Maarten van Steen", Seite 494 f.

--emptyvi

Binden führt dazu, dass im Addressraum des Prozesses am Client ein Proxy angelegt wird, der eine Schnittstelle mit Methoden enthält, die der Prozess aufrufen kann.

Es gibt global und local object references.

- Global References werden bei implizitem Binding verwendet. Hierbei kann der Client direkt auf einer Referenz des Objektes die Methoden aufrufen.

- Explizites Binding verwendet sowohl lokale als auch globale Referenzen. Hier muss das Verteilte Objekt manuell an den lokalen Proxy gebunden werden. dh, es muss zuerst explizit ein Binding durchgeführt werden, bevor Methoden aufgerufen werden können.

Das Binding kann dabei immer nur an eine OR (object reference) geschehen. Diese muss genug Information darüber enthalten, dass ein Client ein Object binden kann. Eine simple OR wäre zB die IP-Adresse + Endpoint der Kommunikation (+ Object ID dort). Weiters müssen noch Infos wie zB das Protokoll, das Error Handling usw enthalten sein.

CORBA verwendet ausserdem die Interoperable Object Reference (IOR), welche alle Informationen beinhaltet um einen Kommunikationskanal zu einem Objekt aufzubauen. Diese beinhalten:

- Art des Kommunikationsprotokolls

- Angaben zum Ort des Objektes, wie im Fall von TCP/IP eine IP-Adresse und ein Port

- Vorgaben zur Darstellung von Text und Daten, wie Codepages, Endian, Verschlüsselung oder Kompression der Daten

- Angaben zur Identität des Objekts im Zielsystem

Um eine IOR zu erhalten, kann der Client den CORBA Naming Service verwenden.

Vergleichen Sie (exemplarisch) CORBA und Java in Bezug auf Objektreferenzen

Hier glaube ich, dass folgendes gemeint ist: während RMI Java spezifisch ist, muss es sich nicht um sprachenunabhängige Darstellungen von Objekten und somit auch von Objektreferenzen kümmern. CORBA hingegen (siehe 10.4.1 im Buch) hat eine andere Darstellung. Für CORBA hat eine Darstellung einer Referenz immer nur im Kontext des speziellen Prozesses eine Bedeutung. Man kann also nicht so einfach eine Referenz von C++ auf ein Java System übergeben. Deshalb hat CORBA die IORs eingeführt, um eine system- und sprachenunabhängige Darstellung von Objekten und Referenzen zu erreichen.

Kann das sein?

Static/Dynamic Invocation[Bearbeiten | Quelltext bearbeiten]

Frage: Was versteht man unter "static" und "dynamic" Invocation von verteilten Methoden? Geben Sie Beispiele an.

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Static\/Dynamic Invocation\s*/si}}

Static Invocation setzt voraus, dass die Schnittstellen eines Objektes bereits bekannt sind. Eine Änderung erfordert eine Neukompilierung am Client.

Bsp. MyObject.doSomething(in1, in2, out1, out2)

Dynamic Invocation erlaubt es den Namen der Methode des verteilten Objekts, die es aufrufen will, zur Laufzeit zu bestimmen.

Bsp. invoke(MyObject, id(doSomething), in1, in2, out1, out2).

Id() bezeichnet hier den Look-up nach dem Methodennamen (z.B. aus einem Directory Service).

Anm. koDiacc: in PHP könnte dynamic Invocation zB so aussehen. $function_name = "getItDone"; $function_name();

es wird somit die function getItDone() aufgerufen. Sichere Variante wäre is_callable(). Ist nun vielleicht nicht die richtige Antwort im Bezug auf VS, aber mir hats geholfen, das besser zu verstehen :)

Quelle: https://web.archive.org/web/20180817172248/http://www.recessframework.org/page/php-callables-is-callable-call-user-func-array-reflection

Anwendungen von dynamic Invocation:

object browser, run-time inspection, batch processing, frameworks

Parameterübergabe bei RMI?[Bearbeiten | Quelltext bearbeiten]

Frage: Wie funktioniert die Parameterübergabe bei RMI? Gehen Sie dabei auf jene Eigenschaften der Objektorientierung ein, welche den Vorteil von RMI gegenüber RPC bewirken.

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Parameterübergabe bei RMI\?\s*/si}}

In Java geht man davon aus, dass die Parameter einer Methode Eingabeparameter sind und dass es sich beim Ergebnis einer Methode um einen einzelnen Ausgabeparameter handelt. Für das Marshalling der von Argumenten und Ergebnissen wird die Serialisierung von Java verwendet. Somit kann jedes Objekt, das serialisierbar ist in Java RMI als Argument oder Ergebnis übergeben werden.

In Java war es wichtig, ein hohes Maß an Verteilungstransparenz zu erreichen und Remote Calls soweit wie möglich wie lokale aussehen zu lassen.

Das Prinzip der Stubs bleibt unverändert. Der Client-Stub wird hier als Proxy, der Server-Stub als Skeleton bezeichnet. Der Client übergibt bei RMI lokale Objekte als Methodenparameter dem Proxy mittels Copy/Restore, entfernte Objekte hingegen können als Referenz übergeben werden. ? Entspricht der OO.

Eine Referenz auf ein Verteiltes Objekt beinhaltet folgende Informationen:

- Netzwerkadresse

- Endpunkt des Servers

- lokaler Bezeichner des echten Objekts (nur von Server verwendet)

In einem RPC werden alle Methodenparameter immer mittels Copy/Restore Variante übergeben.

In beiden Fällen werden die Parameter schlussendlich vom Proxy gemarshalled und an den Server-Stub/Skeleton gesendet.

mehr infos => siehe p.460 Kapitel 10.3.3 (lokale Objekte können kopiert werden, remote Objects per Reference übergeben)

Unterschied zu RPC ist, wenn Referenzen zu einem wiederum entfernten Objekt übergeben werden, werden diese nicht durch copy/Restore übergeben sondern wieder als Referenz, um die sich dann der Server weiter kümmert.

EDIT: ich glaube folgendes trifft es besser:

Vergleich: Verteile Systeme 2003 (s.114 Kapitel 2.3.4 Parameterübergabe)

Weil die meisten RMI Systeme systemübergreifende Objektreferenen unterstützen, ist die Parameterübergabe in Methodenaufrufen im Allgemeinen weniger eingeschränkt als bei RPCs.

Bei RMIs können Objektreferenzen konistent als Parameter in Metohdenaufrufen verwendet werden. Die Referenz wird als Wert übergeben und somit von einer Maschine auf die andere kopiert. Eine ausschließliche Verwendung von Objektreferenten kann aber sehr inefektiv sein. Z.B. Dann wenn es sich lediglich um kleine Objekte wie Integers oder Boolsche Werte handelt. Hierbei muss für jeden Aufruf eine Aufforderung in verschiedenen Adressräumen und noch schlimmer zwischen verschiedenen Maschienen gemacht werden.

Deshalb werden Referenzen auf entfernte Objekte und solche auf lokale Objekte häufig unterschiedlich behandelt: Wird eine Methode mit einer Objektreferenz als Parameter aufgerufen wird diese Referenz nur dann kopiert und als Wertparameter übergeben, wenn es sich auf ein entfernetes Objekt bezieht. In diesem Fall wird das Objekt tatsächlich als Referenz übergeben. Bezieht sich die Referenz jedoch auf ein lokales Objekt (selber Adressraum wie Client), so wird das refenzierte Objekt als ganzes kopiert und zusammen mit dem Aufruf übergeben. Also wird das ganze Objekt als Wert-Parameter übergeben.

TODO: Wie spielt dies mit der OO zusammen?

Message-orientierte Kommunikation[Bearbeiten | Quelltext bearbeiten]

Frage: Erläutern Sie die Grundprinzipien (Kategorien) von Message-orientierter Kommunikation und gehen Sie auf CORBA Messaging exemplarisch ein. Beschreiben Sie zwei unterschiedliche Methoden, wie asynchrone Methodenaufrufe in CORBA Messaging erfolgen können.

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Message-orientierte Kommunikation\s*/si}}

Message Orientierte Kommunikation basiert auf Nachrichten, die zwischen den einzelnen Systemen hin und hergeschickt werden und bieten Unterstützung für persistente/transiente, synchrone/asynchrone Kommunikation (MoM: persistent asynchron durch Queues; Message Passing Interface: transient synchron/asynchron).

Wichtig zu wissen bei den Queues ist folgendes: es gibt im Prinzip trotzdem keine Garantie, dass eine Message jemals gelesen wird, auch wenn sie in die Queue aufgenommen ist. Es kann also sein, dass es nie zu dem kommt. Dies ermöglicht aber genauso eine sehr lose Kopplung von Software!

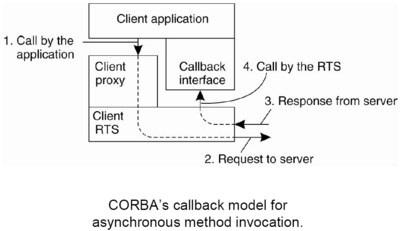

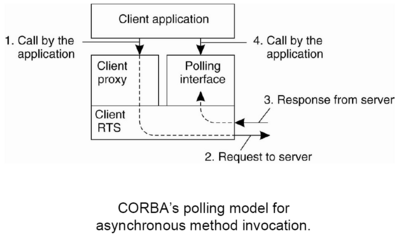

CORBA Messaging verbindet Methodenaufrufe und objektbasierte Nachrichtenübermittlung mitteinander.

CORBA stellt dafür prinzipiell einen Nachrichtendienst zur Verfügung, über den persistente asynchrone Kommunikation trotz konsequenter objektbasierter Handhabung möglich wird.

Es gibt 2 Formen eines asynchronen Aufrufs:

- Callback-Model: Zu jeder ursprünglichen Schnittstelle werden 2 neue Schnittstellen erzeugt, wobei eine dem Aufruf dient (Parameter enthalten keine Return Werte), und eine als Callback fungiert (Parameter sind Rückgabewerte der urspr. Schnittstelle). Sobald eine Antwort eintrifft, wird der Callback mit den Return Werten des Aufrufs ausgelöst. (Resultat der Invocation wird automatisch an Anwendungsebene weitergegeben, sobald sie verfügbar ist). Der Client muss eine Implementierung des Callbacks zur Verfügung stellen.

- Polling-Model: Zu jeder ursprünglichen Schnittstelle werden 2 neue Schnittstellen erzeugt, wobei eine dem Aufruf dient (Parameter enthalten keine Return Werte) und eine Schnittstelle (Parameter sind Rückgabewerte der urspr. Schnittstelle), welche es der Anwendungsebene erlaubt, eingegangene Nachrichten (Resultate der Invocation) abzufragen. Dies muss von der Anwendungsebene explizit angestossen werden.

Beide Methoden können aus der ursprünglichen Schnittstelle automatisch generiert werden.

In beiden Fällen bleibt es dem Client überlassen, sich für synchrone oder asynchrone Kommunikation zu entscheiden und berühren den Server nicht.

Message-oriented Middleware[Bearbeiten | Quelltext bearbeiten]

Frage: Was versteht man unter "Message-oriented Middleware MoM"? Erläutern Sie Modell und Architektur solcher "Message-Queueing"-Systeme. Erklären Sie die Primitivoperationen Put, Get, Poll und Notify eines Message-Queuing Systems. Diskutieren Sie Einsatzzwecke sowie Vor- und Nachteile - gehen Sie insbesonders auf den Begriff des Message Brokers und dessen Bedeutung für EAI ein.

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Message-oriented Middleware\s*/si}}

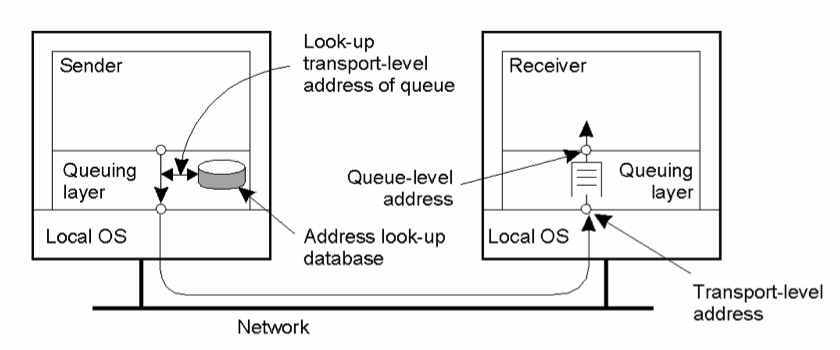

MoM bieten Unterstützung für persistente asynchrone Kommunikation. Anwendungen kommunizieren, indem sie ihre Nachricht in eine Message Queue einstellen. Jede Anwendung hat ihre eigene Queue von der sie liest.

Ein Sender einer Nachricht erhält nur eine Garantie, dass die Nachricht irgendwann in die Queue eingefügt wird.

Vorteil: Empfänger kann passiv sein während Sender sendet und umgekehrt (loosly-coupling).

Für das loosely-coupling gibt es 4 Kombinationen:

- Sender running - Receiver running

- Sender running - Receiver passive

- Sender passive - Receiver running

- Sender passive - Receiver passive

Nachteil: Übertragung kann sich im Minutenbereich abspielen.

Architektur:

- Get: blockt solange die Queue leer ist; gibt ansonsten die erste Nachricht zurück

- Put: hängt eine Nachricht an eine Queue an

- Poll: Queue nach Nachrichten durchsuchen, gibt die erste Nachricht zurück. Blockt niemals.

- Notify: installiert einen Handler, der aufgerufen wird, wenn eine Nachricht in die Queue gestellt wird.

MoM erlaubt es loosly-coupled Systems zusammenzuarbeiten. Unterschiedliche Systeme kommunizieren möglicherweise über unterschiedliche Nachrichtenformate, die von anderen Systemen nicht verstanden werden.

Message-Broker und Einsatz in EAI: Der Hauptzweck eines Message-Brokers (MB) ist es, eingehende Nachrichten so umzuwandeln, dass sie von der Zielanwendung verstanden werden können. Zusätzlich zu seiner Hauptaufgabe kann ein Message-Broker jedoch noch andere Aufgaben erfüllen - so wird ein Message-Broker etwa für EAI (Enterprise Application Integration) verwendet. Hierbei handelt es sich um ein sogenanntes Publish/Suscribe-Modell. Hierbei senden Anwendungen Veröffentlichungen zum Thema X an den Broker, der diese Veröffentlichungen dann an andere Anwendungen, die Thema X abonniert haben, weiterleitet. (lt. Verteilte Systeme - Principles and Paradigms (Tanenbaum) Seite 175 f.).

Stream-orientierte Kommunikation[Bearbeiten | Quelltext bearbeiten]

Frage: Erklären Sie "stream-oriented communication". Was ist "QoS" und inwiefern ist es für stream-oriented communication von Bedeutung?

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Stream-orientierte Kommunikation\s*/si}}

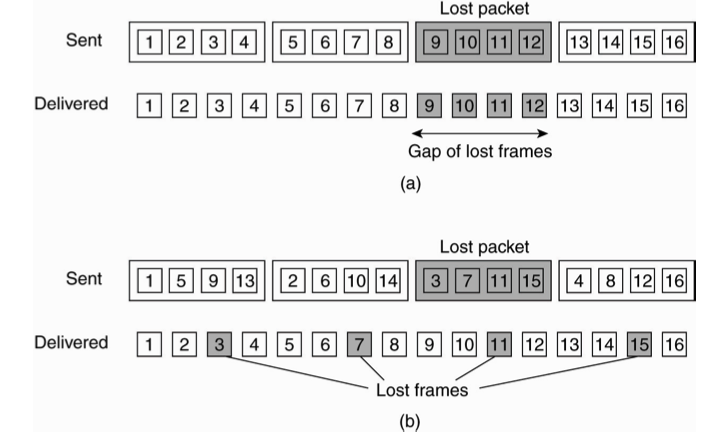

Ein Datenstream ist nichts weiter als eine Folge von Dateneinheiten. Sie können sowohl auf kontinuierliche (Audio, Video), als auch auf diskrete Medien angewendet werden. Die zeitliche Abfolge ist für das Streaming von größter Bedeutung, damit die Daten rechtzeitig beim Client eintreffen.

- asynchron: keine zeitliche Beschränkung (Dateidownload)

- synchron: maximale End-to-End Verzögerung (Sensorenbeispiel: ein Sensor liefert in einer bestimmten Rate Signale. Diese müssen an den Empfänger übertragen werden. Wenn die Übertragung schneller ist als die Erfassungsrate, ist es ok, wenn sie langsamer ist als die Erfassungsrate, dann gibts Probleme)

- isochron: minimale und maximale End-to-End Verzögerung (Audio / Video Stream): hier muss die Übertragung zeitgerecht erfolgen. Siehe Audio + Video Stream - beide sollten die gleiche Verzögerung haben, sonst stimmt das Endergebnis nicht zusammen.

Ein einfacher Stream besteht aus einer Datenfolge (z.b. Mono Audio).

Ein komplexer Stream beinhaltet mehrere Substreams die in zeitlicher Abhängigkeit zueinander stehen (Stereo-Audio, Video mit Tonspuren).

QoS (Quality of Service)= Anforderung an zeitliche Steuerung.

Solche Anforderungen beschreiben zB was von einem darunterliegenden VS und Netzwerk erwartet wird um sicherzustellen, dass bestimmte Dienste noch korrekt ausgeführt werden können.

- Erforderliche Bit-Rate

- max. Verzögerung bei Session beginn

- max. End-to-End Verzögerung

- max. Jitter (Verzögerungsvarianz)

- max. Umlaufverzögerung

Um Jitter zu vermeiden, wird ein Buffer verwendet. Somit können kleine Unregelmäßigkeiten im Datenstrom ausgeglichen werden.

Wenn ein Packet mehrere (Audio und/oder Video) Frames enthält und verloren geht, dann kann eine große Lücke beim Abspielen entstehen. Durch verschachtelte Rahmen (interleaved transmission) kann dieser Effekt reduziert werden. Dafür muss aber eine größere Start Verzögerung in Kauf genommen werden.

Operating System Support[Bearbeiten | Quelltext bearbeiten]

- Buch: 10.2.1, Kap. 3

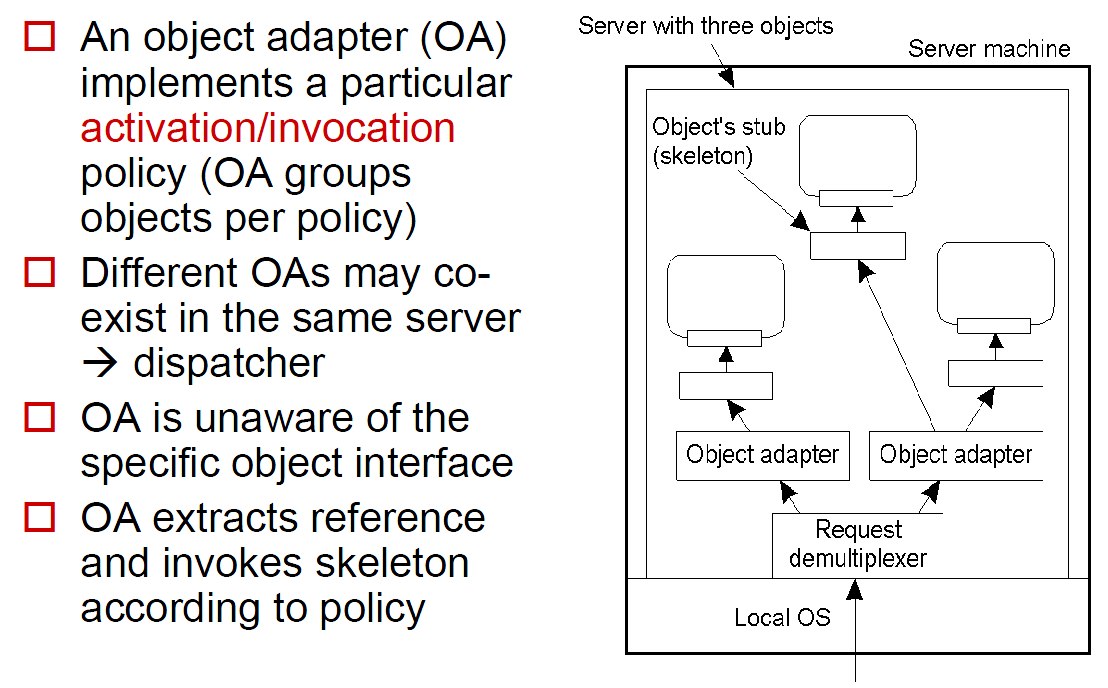

Interessierte finden zum Thema Client in dem Paper über die Entwicklung von User Interface Tools weitere Informationen. Interessierte finden in der CORBA Spezifikation im Kapitel 11 (POA - Portable Object Adapter) eine konkrete Umsetzung des allgemeinen Objekt-Adapter-Konzeptes.

Prozesse & Threads[Bearbeiten | Quelltext bearbeiten]

Frage: Was ist der Unterschied zwischen Prozess und Thread? Was ist beim Einsatz von Multi-Threading zu beachten? Welche Bedeutung haben Threads in verteilten Systemen, insbesonders in Client/Server-Umgebungen?

{{#dpl:resultsheader=Diese Frage wurde bereits in folgenden Prüfungen gestellt: |oneresultheader=Diese Frage wurde bereits in der folgenden Prüfung gestellt: |noresultsheader=* Diese Frage wurde noch nie gestellt! |skipthispage=no |shownamespace=false |uses=Vorlage:Kapitel |replaceintitle=/Verteilte Systeme VO \(Göschka\)\/Prüfung/, |include={Kapitel}.dpl |includematch=/\|\s*TU Wien:Verteilte Systeme VO \(Göschka\)\/Fragenkatalog Wiki\s*\|\s*Prozesse & Threads\s*/si}}

Prozess-Eigenschaften:

- ist ein Programm in Ausführung auf einem virtuellen Prozessor

- ist eine Einheit des Ressourcenbesitzes und -schutzes: hat eigenen Addressraum und schützt diesen von anderen Prozessen

- Nebenläufigkeitstransparenz durch den Hardware-Support des Beetriebssystems

- ist eine Einheit der Verteilung: wird vom Betriebssystem geplant und erstellt

- bedeutet hohe Kosten für Erstellung und Wechseln

- Wenn die maximale Anzahl von Prozessen im Arbeitsspeicher erreicht ist, muss sogar Swapping verwendet werden (Austausch von Prozessen auf dem Arbeitsspeicher mit Prozessen auf der Festplatte)

- Granularität ist nicht ausreichend

Thread-Eigenschaften:

- führt wie Prozess eigenen Code aus, aber ohne Nebenläufigkeitstransparenz

- bedeutet einen Trade-Off: Robustness vs. Effizienz

- Schutz der Ressourcen bleibt dem Applikationsentwickler überlassen

- werden innerhalb eines Prozesses ausgeführt und erlauben nebenläufige Ausführung

- haben nur minimale Informationen, die für das Sharing von Ressourcen benötigt werden wie z.B.: CPU, Scheduling Information, Synchronisation

- Prozess bleibt die Einheit des Ressourcen-Managements und Schutzes, Thread wird die Einheit der Verteilung

Worauf bei Multithreading geachtet werden muss:

- Safety - wie man Threads synchronisiert damit Sie sich nicht gegenseitig beeinflussen

- Liveness — Deadlocks vermeiden um dafür zu sorgen dass jeder Thread Fortschritt macht (Fairness!)

- Performance – Overhead (Performance Strafe) durch context switching und synchronisieren

Welche Bedeutung hat Threads in verteilten Systemen, inbesondere Client-Server Umgebungen?

- allgemein verbesseren Threads die Struktur eines Prozesses (großen Programmes)

- Reaktiv (Server) - Applikation kann mehrere Incoming Events von Clients bearbeiten

- Interaktiv (Client) - ein Thread antwortet auf Benutzerinteraktion, ein anderer erledigt Hintergrundarbeiten (vermeidet Blockierung und beschleunigt die gefühlte Geschwindigkeit)

Verteilte Systeme auf Client-Seite[Bearbeiten | Quelltext bearbeiten]

Frage: Welche Aspekte Verteilter Systeme sind auf Client-Seite zu berücksichtigen? Wie werden User Interfaces in die Architektur Verteilter Systeme eingebunden? Wie können dabei verschiedene Arten der Transparenz unterstützt werden?