TU Wien:Statistik und Wahrscheinlichkeitstheorie VO (Dutter)/Ausarbeitung mündlicher Prüfungsfragen

Vorwort[Bearbeiten | Quelltext bearbeiten]

Diese Ausarbeitung dient dem einfacheren und übersichtlicheren Lernen. Es sei aber gesagt, dass es wahrscheinlich nicht ausreicht nur die Fragen hier zu lernen, da nicht alles vorkommt, was auch tatsächlich gefragt wird (obwohl die Überdeckungswahrscheinlichkeit schon eher so 90% ist schätze ich) und teilweise die Ausführungen an manchen Stellen zu kurz sind. Vor allem die späteren Kapitel (die fast immer gefragt werden): Analytische Statistik, varianzanalyse, Regression/Korrelation sollte auf jeden Fall in kooperation mit dem Skriptum oder anderen Resourcen gelernt werden.

Anmerkung: Dutter möchte meistens auch die grafische Darstellung von Parametern wissen. Konkretes Beispiel: Wo sieht man das in der Normalverteilung?

Weiters sollten auch die wichtigsten Formeln auswendiggelernt werden (Teststatistiken, wie man die Parameter ausrechnet). Herleitungen werden nicht immer verlangt, geben aber sicher Bonsupunkte.

Versionen[Bearbeiten | Quelltext bearbeiten]

Diese Ausarbeitung von Prüfungsfragen, die häufig zur mündlichen Prüfung kommen, wurde ursprünglich von michi204 ausgearbeitet (hier gepostet). Die Version, die dieser Version zugrunde liegt, wurde von dodlhuat weiter verbessert und hier gepostet. Neu strukturiert und Detail-erweitert von For3st (2009/08).

Beschreibende Statistik[Bearbeiten | Quelltext bearbeiten]

Welche Momente einer Verteilung gibt es?[Bearbeiten | Quelltext bearbeiten]

Siehe auch Kapitel 3.3, S. 25 ff..

1. Momente (Lageparameter)[Bearbeiten | Quelltext bearbeiten]

- Der Mittelwert oder Erwartungswert ("arithmetische Mittel"):

- Der Median ist der mittlere Wert einer geordneten Stichprobe bzw. das arithmetische Mittel der beiden mittleren Werte bzw. er ist das 50%-Quantil ( siehe Quantil).

- Der Modus oder Modalwert ist der häufigste Wert einer Verteilung. Sind mehrere Werte gleich häufig, wird die Mitte dieser Werte angenommen, falls die Werte nebeneinander liegen, ansonsten ist der Modalwert undefiniert.

- Bei einem -Quantil ist ein -Anteil der Verteilung kleiner oder gleich und ein ()-Anteil grösser oder gleich . Der Wert der Verteilungsfunktion ergibt also für das -Quantil genau .

- Ein Perzentil ist analog, nur mit Prozentangaben, definiert.

- Quartile sind die .25- bzw. .75-Quantile (identisch mit den 25%- und 75%-Perzentilen).

2. Momente (Streuungsparameter)[Bearbeiten | Quelltext bearbeiten]

- Die Varianz ist das mittlere Abstandsquadrat vom Mittelwert: .

- Die Standardabweichung oder Streuung ist die Wurzel der Varianz, also . Eine "grobe Faustformel" für die Streuung ist

- Der Interquartilabstand IQR ACHTUNG: ist die approximierte Standardabweichung durch den IQR. Das ist nicht der IQR selber.

- Der Median der absoluten Abweichung vom Median Medmed

3. Moment (Schiefe)[Bearbeiten | Quelltext bearbeiten]

Die Schiefe ist grösser als Null wenn es mehr positive als negative Abweichungen vom Mittelwert gibt:

4. Moment (Kurtosis)[Bearbeiten | Quelltext bearbeiten]

Die Kurtosis (auch Wölbung oder Exzess) wird auch "heavy tails" genannt, sie ist ein Maß für die "Flachheit einer Verteilung".

Bei Schiefe und Kurtosis hat es sich eingebürgert, einfach durch n zu dividieren. Durch das Subtrahieren von 3 hat die N(0,1)-Verteilung eine Kurtosis von 0.

Was ist das Messniveau? Welche Skalen gibt es, was charakterisiert sie, welche Momente sind dort verwendbar?[Bearbeiten | Quelltext bearbeiten]

Das Messniveau gibt eine Unterteilung in verschiedene Datentypen / Skalen vor:

- Nominalskala

- z.B. Geschlecht: keine Ordnung, Modalwert

- Ordinalskala

- z.B. Schulnoten: Ordnung, aber keine Abstände: Modalwert, Median, Quantile

- Intervallskala

- z.B. Temperatur °C: Ordnung, Abstände, kein abs. Nullpunkt: Modalwert, Median, Quantile, Mittel

- Verhältnisskala

- z.B. Temperatur in Kelvin: Ordnung, Abstände, absoluter Nullpunkt: Modalwert, Median, Quantile, Mittel

Was ist der MedMed?[Bearbeiten | Quelltext bearbeiten]

Der MedMed, oder kurz MAD (Median Absolute Deviation) ist ein robustes Streuungsmaß. Es wird berechnet, indem man den Median berechnet und dann alle Abweichungen der Datenwerte von Median berechnet. Diese Abweichungen sortiert man nun der Größe nach und wählt wieder den Median (daher auch der Name MedMed).

Achtung: Bei der Verwendung des MedMed gibt es einen Faktor zu berücksichtigen, damit der Wert des MAD mit der Standardabweichung vergleichbar ist! Ähnliches gilt beim durch den IQR (Inter-Quartil-Range) approximierte Standardabweichung

Was ist die Varianz? Warum n-1 Freiheitsgrade?[Bearbeiten | Quelltext bearbeiten]

Die Varianz ist ein Maß, das beschreibt, wie stark eine Messgröße (genauer eine Zufallsgröße) „streut“. Sie wird berechnet, indem man die Abstände der Messwerte vom Mittelwert quadriert, addiert und durch die Anzahl der Messwerte teilt.

Die Formel:

(manchmal "korrigierte Stichprobenvarianz" oder "empirische Varianz" genannt, meist mit s² statt σ² dargestellt)

Man geht von n unabhängigen Stichprobenwerten aus, also n Freiheitsgraden. Da man jedoch die Differenz vom bereits bekannten Mittelwert bildet und die Summe aller Abweichungen 0 ist, kennt man bei n-1 Abweichungen bereits auch die letzte Abweichung, daher n-1 Freiheitsgrade. Ein nicht unerwünschter Nebeneffekt ist, das die Varianz nun für n=1 nicht definiert ist statt 0.

Video wo rechnerisch skizziert wird warum die Formel mit dem n-1 eine bessere Erwartungstreue hat: [1]

Wikipedia rechnet die Erwartungstreue auch vor.

Was ist die Standardabweichung?[Bearbeiten | Quelltext bearbeiten]

Die Standardabweichung (oder Streuung) ist die mittlere Abweichung vom arithmetischen Mittel einer Verteilung. Sie berechnet sich aus der Quadratwurzel der Varianz und ist ein Streuungsmaß, gibt also die Breite der Verteilung an. Eine sehr grobe Schätzung für die Standardabweichung lautet:

Wahrscheinlichkeitstheorie[Bearbeiten | Quelltext bearbeiten]

(Elementar-)Ereignisse, Ereignisalgebra, Ereignisraum, Operationen, Borel-Mengen[Bearbeiten | Quelltext bearbeiten]

Siehe auch Kapitel 4.1

Führt man einen Versuch (z.B. Würfeln mit 2 Würfeln) durch, kann dieser verschiedene Versuchsausgänge haben ((1,1), (1,2), … , (6,6)). Die Menge aller möglichen Versuchsausgänge heißt Ω (Stichprobenraum), und jede Teilmenge (z.B. 2 gleiche = {(1,1),(2,2), …, (6,6)} heißt Ereignis, einpunktige Teilmengen (z.B. (1,1)) heißen Elementarereignisse.

Auf Ereignisse kann man folgende Operationen anwenden:

- Durchschnittsbildung ("A und B": )

- Vereinigung ("A oder B": )

- Komplementbildung ("nicht A": )

Besondere Ergeinisse:

- Das unmögliche Ereignis Ø zb:

- Das sichere Ereignis Ω zb:

Ereignisse können disjunkt sein (ihr Durchschnitt ist leer). Ein Ereignis A kann ein anderes B implizieren (), dh A ist in B enthalten. Eine Reihe von Ereignissen ist genau dann Zerlegung eines anderen Ereignisses, wenn ihre Vereinigung das andere Ereignis ergibt und sie alle disjunkt sind. Die Regeln von De Morgan gilt daher:

und

Die Menge aller betrachteten Ereignisse daher die Menge aller Teilmengen von Ω heißt Ereignisraum A (z.B. ). Zusammen mit den Operationen (Durchschnitt, Vereinigung, Komplementbildung), dem sicheren Ereignis Ω und Ø (unmögliches Ereignis) heißt der Ereignisraum Ereignisalgebra. Ist diese bezüglich Vereinigung und Komplementbildung abgeschlossen, heißt sie Ereignis-σ-Algebra.

Ist die Menge aller möglichen Versuchsausgänge , und nimmt man als Ereignisalgebra die Menge aller links halboffenen Intervalle sowie Vereinigungen und Komplemente dieser, dann ist die kleinste σ-Algebra, die all diese Mengen enthält, die borelsche σ-Algebra B, Teilmengen davon Borel-Mengen.

Welche Arten von Wahrscheinlichkeiten gibt es?[Bearbeiten | Quelltext bearbeiten]

Während die a-priori-Wahrscheinlichkeit theoretischer Natur ist und im Vorhinein angegeben wird (Münze hat 2 gleich wahrscheinliche Seiten, daher ), bestimmt man die a-posteriori-Wahrscheinlichkeit empirisch (57 von 100 Münzwürfen haben Wappen gezeigt, daraus folgt: ).

Was ist ein Wahrscheinlichkeitsmaß?[Bearbeiten | Quelltext bearbeiten]

Siehe auch Kapitel 4.2 (S. 39).

Ein Maß μ weist jedem Elementarereignis aus Ω und damit jedem Ereignis aus A ein Gewicht zu, ist also eine Funktion vom Ereignisraum A in . Für Maße gilt natürlich σ- Additivität, dh die Summe aller Maße einer Zerlegung eines Ereignisses ergibt das Maß dieses Ereignisses. Gilt auch μ(Ω) = 1, hat man ein Wahrscheinlichkeitsmaß, und man schreibt fortan P statt μ. Die Wahrscheinlichkeit eines Ereignisses ist dann die Summe der Wahrscheinlichkeiten seiner Elementarereignisse. Sind alle Gewichte gleich, ist die Wahrscheinlichkeit eines Ereignisses gleich der Anzahl der günstigen dividiert durch die Anzahl der möglichen Elementarereignisse.

Rechenregeln:

Was ist ein Wahrscheinlichkeitsraum?[Bearbeiten | Quelltext bearbeiten]

Die Menge aller möglichen Versuchsausgänge Ω zusammen mit der darauf definierten σ-Algebra

Referenzfehler: Für ein <ref>-Tag fehlt ein schließendes </ref>-Tag.

Was ist eine bedingte Wahrscheinlichkeit? Was bedeutet Unabhängigkeit von Ereignissen?[Bearbeiten | Quelltext bearbeiten]

Durch das Vorwissen wird der Ereignisraum eingeschränkt, sodass die Wahrscheinlichkeiten sich ändern (z.B. 1 Würfel mit den Ereignissen A: "Zahl≤3" und B: "Zahl=1". Dann ist , aber es gilt ).

Es gilt: , also die Wahrscheinlichkeit für A und B, normiert auf den durch den Eintritt von A bereits eingeschränkten Ereignisraum. Wenn der Eintritt von A keinen Einfluss mehr hat, daher P(B|A) = P(B), nennt man die Ereignisse A und B unabhängig. Aus obiger Formel erhält man: . Für unabhängige Ereignisse gilt dann wegen -> .

Was ist eine Zufallsvariable? Wann ist sie diskret/kontinuierlich? Was ist eine Dichtefunktion? Was ist eine Verteilungsfunktion? Transformationen von Zufallsvariablen?[Bearbeiten | Quelltext bearbeiten]

Eine Zufallsvariable ist formal eine Abbildung von einem Wahrscheinlichkeitsraum [1] in einen einfacheren [1]. Jede Menge B aus [1] muss ein Urbild besitzen.

Eine diskrete Zufallsvariable kann höchstens abzählbar viele verschiedene Werte annehmen. gibt eine Punktwahrscheinlichkeit an und heißt Wahrscheinlichkeitsfunktion, und es gilt .

ist gleich der Summe über bis x und heißt Verteilungsfunktion.

Eine Zufallsvariable ist stetig, wenn es eine nicht negative Funktion f(x) gibt ,sodass sich die Verteilungsfunktion F(x) für alle als Integral über f darstellen lässt.

Die Verteilungsfunktion ist gleich dem Integral über f von . f heißt Dichtefunktion und ist die Ableitung der Verteilungsfunktion.

Transformationen von Zufallsvariablen: Addition wirkt sich nur auf den Mittelwert aus (verschiebt sich um addierten Betrag), Multiplikation wirkt sich auf die Varianz aus (diese wird dividiert). Zieht man den Mittelwert einer normalverteilten Zufallsvariablen ab und dividiert durch die Standardabweichung, erhält man eine N(0,1), also standard-normalverteilte Zufallsvariable.

Was ist ein Wahrscheinlichkeitsnetz?[Bearbeiten | Quelltext bearbeiten]

Im Wahrscheinlichkeitsnetz trägt man die Werte einer geordneten Stichprobe sowie die empirische Verteilungsfunktion auf. Bei Normalverteilung ergibt sich durch die Anordnung der y-Achse annähernd eine Gerade. Aus der Ausgleichsgeraden lassen sich die Parameter der Verteilung grafisch schätzen. bei 50% und bei 84,13% s

http://de.wikipedia.org/wiki/Empirische_Verteilungsfunktion

Was ist die mathematische Erwartung und die Varianz einer Zufallsvariablen?[Bearbeiten | Quelltext bearbeiten]

Die Erwartung (oder der Mittelwert) einer Zufallsvariablen X ist im stetigen Fall das Integral der Dichtefunktion mal h(x)=x:

und im diskreten Fall:

Die Varianz einer Zufallsvariablen X ist:

Dutter ist hier lieber die nicht ausmultiplizierte Form zu verwenden:

Die Standardabweichung einer Zufallsvariablen ist .

Was ist eine mehrdimensionale (multivariate) Zufallsvariable? Was ist eine Randverteilung? Wann sind zwei Zufallsvariablen voneinander unabhängig?[Bearbeiten | Quelltext bearbeiten]

Siehe auch Kapitel 4.5, S. 60 ff..

In der Praxis wird selten eine Größe alleine untersucht, da die Zusammenhänge zwischen verschiedenen Merkmalen wichtig sind. Man kann nun einen p-dimensionalen Zufallsvektor definieren. Verteilungsfunktion und Wahrscheinlichkeitsdichte können ähnlich wie im eindimensionalen Fall definiert werden.

Die Verteilung einer Zufallsvariablen unabhängig vom Wert der anderen (d.h. für alle Werte der anderen) heißt Randverteilung (Kapitel 4.5.1, S. 64).

Zwei Zufallsvariablen X und Y sind genau dann voneinander unabhängig, wenn die Verteilungsfunktion des Zufallsvektors gleich dem Produkt der beiden Randverteilungsfunktionen ist, daher:

Die Randverteilung sieht folgendermaßen aus:

- im diskreten [2] Fall

bzw.- im stetigen Fall

bzw.

| Y/X | 0 | 1 | 2 | 3 | |

|---|---|---|---|---|---|

| 1 | |||||

| 3 | |||||

Was besagt der zentrale Grenzwertsatz?[Bearbeiten | Quelltext bearbeiten]

Besitzt die Verteilung der Grundgesamtheit eine endliche Varianz, was meist der Fall ist, so ist die Verteilung der arithmetischen Mittel von Zufallsstichproben für einen genügend großen Stichprobenumfang annähernd normalverteilt.

Analytische Statistik[Bearbeiten | Quelltext bearbeiten]

Was ist eine Stichprobe?[Bearbeiten | Quelltext bearbeiten]

Eine Untermenge einer Population heißt Stichprobe. Mathematisch gesehen stellt sie einen n-dimensionalen Zufallsvektor mit unabhängig und identisch verteilten Elementen dar. Die Stichprobenwerte sind eine Realisation dieses Zufallsvektors. Damit mit einfachen Mitteln Aussagen über die Verteilung oder ihre Parameter gemacht werden können, müssen die Stichprobenwerte zufällig aus der Population gewählt werden.

Was ist ein Schätzer? Wann ist er erwartungstreu, konsistent, oder effizient?[Bearbeiten | Quelltext bearbeiten]

Ein Schätzer 't' (auch eine Schätzfunktion genannt, siehe auch Skriptum Kap. 5.2, S. 76) berechnet einen Parameter q einer Verteilung näherungsweise aus Stichprobenwerten:

Eine Funktion der Stichprobe wird allgemein als Statistik bezeichnet (und ist auch eine Zufallsvariable). Im Falle der Verwendung zur näherungsweisen Bestimmung (Schätzung) gewisser Kenngrößen spricht man von einem Schätzer. Eine Realisation eines Schätzers heißt Schätzwert oder Schätzung.

Eine Schätzfunktion heißt erwartungstreu, wenn der Erwartungswert der Schätzfunktion den geschätzten Parameter ergibt.

Eine Schätzfunktion heißt konsistent, wenn sie sich mit wachsendem n (größerer Stichprobe) immer mehr dem geschätzten Parameter nähert, d. h. ihre Varianz kleiner wird.

Ein Schätzer ist dann effizient, wenn er die kleinstmögliche Varianz aufweist.

Wenn die Verteilung symetrisch ist, stellt der Median ebenfalls einen konsistenten und erwartungstreuen Schätzer der Erwartung dar. Die Güte des Schätzers hängt von seiner Variabilität ab, d.h. je kleiner die Varianz desto besser. (1/3 mehr Beobachtungen für um die gleiche Genauigkeit wie bei zu erhalten)

siehe http://www.statistik.tuwien.ac.at/public/dutt/vorles/inf_bak/node46.html

Was macht die likelihood-Funktion? Was ist die Maximum-Likelihood-Methode?[Bearbeiten | Quelltext bearbeiten]

Die Maximum-Likelihood-Methode soll einen brauchbaren Schätzer für Parameter einer Verteilung finden, indem sie jenen Wert des Parameters wählt, der die Stichprobe als wahrscheinlichstes Resultat erscheinen lässt. Dazu wird der Parameter θ so gewählt, dass die Likelihood-Funktion ein Maximum annimmt ( ist die Dichtefunktion der Verteilung).

Was ist ein Konfidenzintervall?[Bearbeiten | Quelltext bearbeiten]

Ein -Konfidenzintervall für einen Parameter ist ein Intervall um den geschätzten Parameter, in dem der tatsächliche Parameter mit der Überdeckungswahrscheinlichkeit liegt. heißt dabei Konfidenzzahl.

Konfidenzintervall für den Mittelwert[Bearbeiten | Quelltext bearbeiten]

Das Konfidenzintervall (siehe auch Kapitel 5.3, S. 79). Zugrunde liegt die Tatsache, dass der Mittelwert einer Normalverteilung selbst einer Normalverteilung unterliegt. Nun wird diese Verteilung so transformiert, dass daraus eine - Verteilung, also eine Standardnormalverteilung, wird. Die Transformation ist nun . Wichtig ist zu erkennen, dass durch diese Transformation tatsächlich aus der -Verteilung für eine -Verteilung wird. Gemäß den Transformationsregeln (S. 29) ergibt die Transformation den Mittelwert

und die Varianz (wobei )

Die Wahrscheinlichkeit, dass der transformierte Mittelwert (der nun standard-normalverteilt ist) nun in den entsprechenden Bereich fällt, entspricht dem -Quantil der Standard-normalverteilung. Es gilt daher:

Wenn die beiden Ungleichungen ausgerechnet werden, ergibt sich die Formel fuer das Konfidenzintervall:

Ist die Standardabweichung unbekannt, wird das Konfidenzintervall länger, da es aus der Stichprobe geschätzt werden muss. Aus der Standard-Normalverteilung wird dann magisch eine Student-t-Verteilung mit n-1 Freiheitsgraden (Warum?). Das Konfidenzintervall sieht dann so aus:

Die t-Verteilung entspricht im Prinzip einer Normalverteilung bei kleinem n, d.h. mit weniger Stichproben. Ab n>30 ist die t-Verteilung durch die N-Verteilung annäherbar. Da ich in der N-Verteilung die Stichprobenanzahl nirgends unterbringen kann, sattel ich in diesem Fall auf die t-Verteilung um und kann statt der Varianz (die ich ja gar nicht weiß) die Stichprobenzahl in Form der Freiheitsgrade hinein bringen. Wenn die Stichprobenzahl groß genug ist, nähert sich die t-Verteilung eh der N-Verteilung an, wenn sie aber eigentlich zu klein ist, dann hab ich mit der t-Verteilung ein viel seriöseres Intervall, das breiter ist, weil ich weniger Informationen habe.

Intervallsschätzung mit bei unbekannten (1-Stichproben-t-Test)[Bearbeiten | Quelltext bearbeiten]

TODO: Herleitung laut Skriptum (Kapitel Intervallsschätzungen -> mit bei unbekannten )

Hypothesen:

Teststatistik:

Kritischer Bereich:

Konfidenzintervall für die Varianz[Bearbeiten | Quelltext bearbeiten]

- Konfidenzintervall für (siehe auch Kapitel 5.8.1, S. 97)

Was ist eine Hypothese? Was ist die Nullhypothese, was die Alternative? Fehler 1./2. Art?[Bearbeiten | Quelltext bearbeiten]

Zusatzinfo: [3]

Hypothesen[Bearbeiten | Quelltext bearbeiten]

Unter Hypothese versteht man in der Statistik eine anhand empirischer Daten zu prüfende Annahme.

Eine Nullhypothese () ist eine Annahme (z.B. über die Verteilung einer Zufallsvariablen oder den Wert eines Parameters), die getestet werden soll.

Die Alternativhypothese () steht für eine Menge von alternativen Annahmen bezüglich der Nullhypothese. Falls die Nullhypothese nicht verworfen werden kann, besteht aus statistischer Sicht allerdings kein Grund, von ihrer Gültigkeit auszugehen (vgl. Fehler 2. Art).

Die Teststatistik ist eine nach einer bestimmten Vorschrift berechnete Zufallsvariable. Fällt der Wert der Teststatistik in den so genannten kritischen Bereich, wird die Nullhypothese verworfen und angenommen.

Fehlerwahrscheinlichkeiten[Bearbeiten | Quelltext bearbeiten]

Die Fehlerwahrscheinlichkeit 1. Art ("-Fehler") gibt die Wahrscheinlichkeit an, dass die richtige Hypothese abgelehnt wird ("false positive"). Er passiert mit der Wahrscheinlichkeit (=Signifikanzniveau). Die Fehlerwahrscheinlichkeit 2. Art ("-Fehler") gibt die Wahrscheinlichkeit an, dass eine falsche Hypothese als richtig angenommen wird ("false negative"). Die Fehlerwahrscheinlichkeiten können durch Vergrößern des Stichprobenumfangs verkleinert werden. Die Wahrscheinlichkeit, mit der eine falsche Nullhypothese entlarvt wird, heißt Macht oder Schärfe eines Tests und kann mit angegeben werden. Anders gesagt: Wenn man in einer Verteilung sich jeweils das ausrechnet und die 1- Werte in einer Kurve aufträgt, kann man in der Kurve die Macht ablesen.

Siehe auch Kapitel 5.5, S. 87 und Hypothese@Wikipedia

2 Populationen[Bearbeiten | Quelltext bearbeiten]

Vergleich der Mittel (2-Stichproben-t-Test) (Spezialfall der Varianzenanalyse)[Bearbeiten | Quelltext bearbeiten]

Man vergleicht damit die Mittel zweier Populationen untereinander (2-Stichproben-t-Test) oder man vergleicht das Mittel einer Population mit einem vorgegebenen Wert (1-Stichproben-t-Test, nur bei unbekannter Standardabweichung).

Hypothesen:

Teststatistik:

Kritischer Bereich:

Vergleich der Varianzen[Bearbeiten | Quelltext bearbeiten]

Mit Hilfe des F-Tests:

Teststatistik:

Kritischer Bereich:

Anpassungstests[Bearbeiten | Quelltext bearbeiten]

Wozu dient der -Anpassungstest?[Bearbeiten | Quelltext bearbeiten]

Mit Hilfe dieses Tests kann man eine Hypothese über die Form einer Verteilung prüfen. Dazu teilt man die Stichprobe in k Klassen ein und berechnet die Teststatistik:

wobei die Häufigkeiten und die theoretischen Wahrscheinlichkeiten (aufgrund der mit angenommenen Verteilung) multipliziert mit sind.

Als kritischen Bereich nimmt man:

Wozu dient der Kolmogorov-Smirnov-Test?[Bearbeiten | Quelltext bearbeiten]

Man testet damit ob zwei Zufallsvariablen die selbe Verteilung haben oder ob einer Zufallsvariable eine hypothetische Verteilung zugrunde liegt, indem man die absolute Differenz zwischen empirischer und hypothetischer Verteilungsfunktion betrachtet.

Varianzanalyse[Bearbeiten | Quelltext bearbeiten]

Was geschieht bei der Varianzanalyse? Was steht in der Varianzanalyse-Tafel?[Bearbeiten | Quelltext bearbeiten]

Eine betrachtete Größe weist oft eine Variation auf, die sich aus zufälliger Variation sowie Variation durch einen bestimmten Einfluss zusammensetzt. In der Varianzanalyse trennt man diese beiden Variationen (Varianzzerlegung). Dazu wird die Quadratsumme (Summe der Abweichungen vom Stichprobenmittel) zerlegt.

Mit Hilfe der Varianzanalyse kann man die Mittelwerte von k Normalverteilungen vergleichen. Man nimmt gegen für mindestens ein . Danach berechnet man die Quadratsumme innerhalb jeder Stichprobe und die Quadratsumme zwischen den Stichproben :

Die Varianzanalyse-Tabelle sieht so aus:

| Variation | Freiheitsgrade FG |

Quadratsumme q |

mittlere Quadratsumme |

F |

|---|---|---|---|---|

| Zwischen den Gruppen | k-1 | |||

| Innerhalb der Gruppe | n-k | |||

| Total | n-1 | q |

Der Wert der Teststatistik F wird nun gegen den kritischen Bereich getestet:

Teststatistik:

Kritischer Bereich:

Regression und Korrelation[Bearbeiten | Quelltext bearbeiten]

Was ist Regression? Was ist das Regressionsproblem? Regressionsgerade? Residuen? Wie testet man auf Abhängigkeit einer Variablen x?[Bearbeiten | Quelltext bearbeiten]

Das Regressionsproblem behandelt die Verteilung einer Variablen Y, wenn (mindestens) eine andere Variable x nicht zufällige Werte annimmt. x heißt unabhängig und ist keine Zufallsvariable. Y ist eine Zufallsvariable und abhängig von x, sofern eine Regression vorliegt. Für jeden gewählten Wert von x gibt es eine Verteilung von Y mit einem Mittelwert und einer Varianz . Liegt eine einfache, lineare Regression vor, so kann die Abhängigkeit der Mittelwerte von Y durch die Regressionsgerade angegeben werden:

Die Parameter der Regressionsgeraden und werden aus den Stichprobenwerten geschätzt, wobei man für den Wert und für den Quotienten verwendet. ist dabei die empirische Varianz der unabhängigen Variable und errechnet sich daher aus:

Die empirische Kovarianz ergibt sich aus der Summe aller Produkte von Mittelabweichungen beider Variablen dividiert durch n-1 Freiheitsgrade:

Auch die Varianz der Beobachtungen kann geschätzt werden durch:

Die Differenzen zwischen gemessenen und geschätzten Werten nennt man auch Residuen. Die Gerade wird so gewählt, dass die Summe der quadrierten Residuen minimal wird.

Nimmt man die Verteilung von Y für jedes x als normal an, kann man Konfidenzintervalle für die Parameter a, b, und angeben (mit Hilfe der Parameterschätzungen und der t-Verteilung, siehe Kapitel 7.3.1, S. 114).

Test auf Regression (Test auf Abhängigkeit)[Bearbeiten | Quelltext bearbeiten]

Die Nullhypothese besagt, dass alle Mittelwerte von Y gleich sind (Alternative ) und daher keine Regression vorliegt. Als Teststatistik verwendet man:

und der kritische Bereich ist:

Da der hier der Betrag angegeben ist, handelt es sich eigentlich um einen zweiseitig begrenzten Bereich, daher ist zu nehmen.

Was ist Korrelation? Was ist das Korrelationsproblem? Was sind Kovarianz, empirische Kovarianz und Korrelationskoeffizient? Wie testet man auf Unkorreliertheit?[Bearbeiten | Quelltext bearbeiten]

Das Korrelationsproblem behandelt die Frage, ob Korrelation vorliegt. Dies ist der Fall, wenn es einen Zusammenhang zwischen den Verteilungen zweier Zufallsvariablen X und Y gibt. Es wird also die gemeinsame Verteilung von X und Y betrachtet, ohne eine Variable zu fixieren. Oft geht man in solchen Problemen von einer bivariaten Normalverteilung aus. Für jedes X gibt es eine Verteilung von Y und umgekehrt.

Die Korrelation ρ zwischen X und Y ergibt sich aus der Kovarianz dividiert durch das Produkt der beiden Standardabweichungen und und ist eine dimensionslose Größe im Intervall (–1,1); bei ρ = 0 sind X und Y unabhängig.

Als Schätzung verwendet man den empirischen Korrelationskoeffizienten, welcher sich wiederum aus der empirischen Kovarianz , dividiert durch das Produkt der empirischen Standardabweichungen und berechnet:

Test auf Unkorreliertheit[Bearbeiten | Quelltext bearbeiten]

Für den Test auf Unkorreliertheit (Test auf Unabhängigkeit, siehe auch S. 118) sind und . Der kritische Bereich ist:

und als Teststatistik verwendet man:

wobei R die Zufallsvariable bezeichnet, die die Werte des empirischen Korrelationskoeffizienten annimmt.

Was ist die Kovarianz ?[Bearbeiten | Quelltext bearbeiten]

(Folgendes ist aus Wikipedia kopiert:)

Die Kovarianz ist in der Statistik eine (nichtstandardisierte) Maßzahl für den Zusammenhang zweier statistischer Merkmale (im Folgenden X und Y).

- Die Kovarianz ist positiv, wenn X und Y tendenziell einen gleichsinnigen linearen Zusammenhang besitzen, d. h. hohe Werte von X gehen mit hohen Werten von Y einher und niedrige mit niedrigen.

- Die Kovarianz ist hingegen negativ, wenn X und Y einen gegensinnigen linearen Zusammenhang aufweisen, d. h. hohe Werte der einen Zufallsvariablen gehen mit niedrigen Werten der anderen Zufallsvariablen einher.

- Ist das Ergebnis 0, so besteht kein Zusammenhang oder ein nicht linearer Zusammenhang z. B. eine U-förmige Beziehung zwischen den beiden Variablen X und Y.

Die Kovarianz gibt zwar die Richtung einer Beziehung zwischen zwei Variablen an, über die Stärke des Zusammenhangs wird aber keine Aussage getroffen. Dies liegt an der Abhängigkeit des Ergebnisses von den Maßeinheiten der beteiligten Variablen X und Y. Ist z. B. die Kovarianz zweier Variablen mit der Maßeinheit "Meter" 5,2 so ist die Kovarianz der gleichen Werte in der Maßeinheit "Zentimeter" 520. Die Kovarianz ist deshalb in ihrer "Rohform" als Maßzahl für den stochastischen Zusammenhang nur wenig anschaulich und auch schwer vergleichbar.

Beispiel des Korrelationskoevizienten bei Scatter-Plot: [4]

Zählstatistik[Bearbeiten | Quelltext bearbeiten]

Was ist das Klassifizierungsproblem? Was ist eine Kontingenztafel? Einfache, Zweifache Klassifizierung ?[Bearbeiten | Quelltext bearbeiten]

Oft möchte man Dinge zählen, die in bestimmte Kategorien fallen. Es gibt das einfache Klassifizierungsproblem (z.B. 4 Klassen für Aussehen von Erbsen nach Kreuzungsversuch) und das zweifache Klassifizierungsproblem (z.B. Haarfarbe und Augenfarbe). Man hat jeweils vorgegebene theoretische Häufigkeiten und untersucht, ob die Abweichungen der tatsächlichen Häufigkeiten von ersteren nur zufälliger Natur sind. Eine Tabelle, die die absoluten Häufigkeiten der Merkmale gemeinsam darstellt, heißt Kontingenztafel. Teststatistik: .

Der kritische Bereich ist eine -Statistik mit k-1 Freiheitsgraden im einfachen und (r-1)(c-1) Freiheitsgraden im zweifachen Fall.

Die Kontingenztafel sieht im einfachen Fall so aus (siehe auch Kapitel 8.1, S. 119):

| Klassen | beobachtet | theoretisch | ||

| Klasse 1 | ||||

| Klasse 2 | ||||

| Klasse k | ||||

| Total |

Und beim Problem der zweifachen Klassifizierung ist das ganze naturgemäß umfangreicher. In der nachfolgenden Tabelle gibt es r Klassen für Merkmal A und c Klassen fuer Merkmal B. Die Einzelnen Zellen geben jeweils die tatsächlich auftretende Häufigkeit () und in Klammer die erwartete Häufigkeit () an:

| Merkmal B | |||||

| Merkmal A | |||||

Ein praktisches Beispiel kann in Kapitel 8.2, S. 120 bewundert werden.

Verteilungen[Bearbeiten | Quelltext bearbeiten]

Im folgenden eine Zusammenfassung der wichtigsten Verteilungen. Vor allem Normalverteilung, Chi-Quadrat-, t- und F- Verteilung sollten gut gelernt werden (Dichtefunktion, etc.). Die Verteilungen sind in ungefährere absteigender Relevanz (für die Dutter Prüfung) geordnet. Nach der Erfahrung kann alles nach Binomialverteilung vernachlässigt werden (keine Gewähr).

Normalverteilung[Bearbeiten | Quelltext bearbeiten]

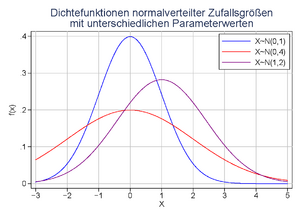

: kontinuierlich, symmetrisch.

Die Normalverteilung gilt zumindest annähernd für viele natürliche Prozesse. Aus dem Zentralen Grenzwertsatz folgt, dass aus vielen einzelnen unabhängigen Einflüssen entstehende Größen normalverteilt sind. Die Normalverteilung ist bei großem n eine gute Näherung für die Binomialverteilung.

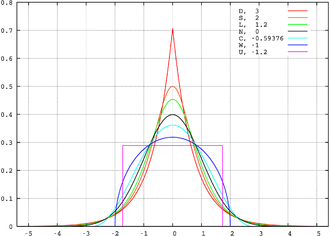

Dichtefunktion: Gaußsche Glockenkurve mit arithmetischem Mittel der Verteilung als Höhepunkt, Mittel ± Standardabweichung als Wendepunkte.

Verteilungsfunktion: Anfang und Ende sehr flach und um den Median sehr steil.

wird auch die Standardnormalverteilung genannt.

Chi-Quadrat-Verteilung[Bearbeiten | Quelltext bearbeiten]

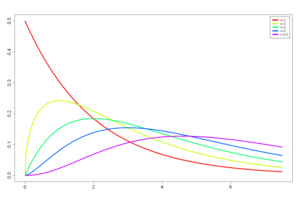

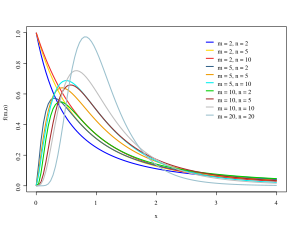

: kontinuierlich, asymmetrisch. n ist der Freiheitsgrad.

Der Erwartungswert ist n, die Varianz 2n. Meist verwendet man die zentrale -Verteilung mit nur einem Parameter n. Die Summe quadrierter Zufallsvariablen (normalverteilt) ist -verteilt. Man verwendet diese Verteilung z.B. zur Schätzung der Varianz. Die -Verteilung ist sozusagen die quadrierte Normalverteilung.

Einige Verwendungszwecke:

- Anpassungstest

- Klassifizierungsproblem

Siehe auch die Chi-Quadrat-Verteilung auf der deutschen Wikipedia.

t-Verteilung[Bearbeiten | Quelltext bearbeiten]

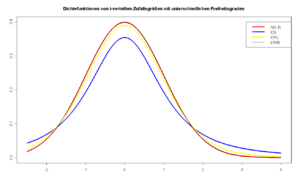

: kontinuierlich, symmetrisch. m sind Freiheitsgrade.

Erwartungswert: 0. Für große m (>30) kann die t-Verteilung durch die -Verteilung angenähert werden.

Die Varianz ergibt sich für als

Einige Verwendungszwecke:

- Schätzung des Erwartungswertes bei unbekannter Varianz verwendet (statt der Standard-Normalverteilung bei bekannter Varianz), mit n-1 Freiheitsgraden

- Test auf Abhängigkeit (Regression), mit n-2 Freiheitsgraden

- Test auf Korrelation, mit n-2 Freiheitsgraden

- 1- und 2-Stichproben-t-Test, mit n-1 Freiheitsgraden

Siehe auch die Studentsche t-Verteilung auf der deutschen Wikipedia.

F-Verteilung[Bearbeiten | Quelltext bearbeiten]

: kontinuierlich, asymmetrisch. m und n sind Freiheitsgrade.

Diese Verteilung ergibt sich aus dem Quotienten zweier Verteilungen mit m bzw. n Freiheitsgraden:

Einige Verwendungszwecke:

- Test auf geiche Varianzen

- Varianzanalyse

Einige Bonusinformationen aus der Wikipedia:

Der Erwartungswert ist nur für definiert und lautet dann

Die Varianz ist nur für definiert und lautet dann

Für manche Tests ist es nützlich zu wissen, dass gilt:

Siehe auch die F-Verteilung auf der deutschen Wikipedia.

Binomialverteilung[Bearbeiten | Quelltext bearbeiten]

: diskret, asymmetrisch.

Für p=0,5 symmetrisch.

Die Binomialverteilung kann zur Beschreibung von n Versuchen, die mit der Wahrscheinlichkeit p erfolgreich sind, verwendet werden. Für große n kann die Binomialverteilung gut durch die Normalverteilung angenähert werden.

(daher mit nur einem Versuch) heißt auch Bernoulli-Verteilung.

Wie lässt sich die Binomialverteilung durch die Normalverteilung annähern?[Bearbeiten | Quelltext bearbeiten]

Für große Werte von n lässt sich die Binomialverteilung durch die Normalverteilung mit dem Mittelwert und der Varianz gut annähern. Für Werte von p nahe 0 oder 1 ist die Verteilung allerdings recht schief, für p nahe 0.5 ist die Annäherung recht gut.

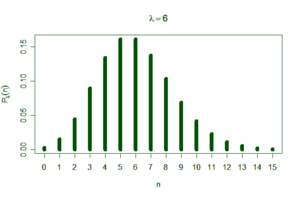

Poissonverteilung[Bearbeiten | Quelltext bearbeiten]

: diskret, asymmetrisch.

λ ist zugleich Erwartungswert, Varianz und Schiefe. Für große kann die Poisson-Verteilung durch die Normalverteilung mit und angenähert werden. Sie ist die Grenzverteilung der Binomialverteilung (für p → 0, n → ∞). Sie wird typischerweise für die Zahl von Phänomenen innerhalb einer Zeiteinheit verwendet.

Siehe auch die Poisson-Verteilung auf der deutschen Wikipedia.

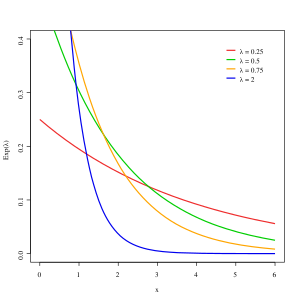

Exponentialverteilung[Bearbeiten | Quelltext bearbeiten]

, kontinuierlich, asymmetrisch

ist der Erwartungswert. Manchmal wird die Exponentialverteilung auch durch die konstante Ausfallsrate beschrieben. Im folgenden sind daher immer zwei Formen für die Exponentialverteilung angebeben. Die Dichtefunktion ist gegeben als:

Die Verteilungsfunktion ist gegeben als

Der Erwartungswert ist dann

und die Varianz ist

Die Exponentialverteilung ist ein Modell fuer die zufaellige Dauer von Zeitintervallen. Eine wichtige Anwendung der Exponentialverteilung ist die Errechnung der "Mean Time Between Failure", also der durschnittlichen Lebenserwartung, von Bauteilen die keiner Alterung unterliegen.

Siehe auch die Exponentialverteilung auf der deutschen Wikipedia. Im Skriptum wird die Exponentialverteilung auch in Kapitel 9.3.1, S. 125 ff. behandelt.

Rechtecksverteilung[Bearbeiten | Quelltext bearbeiten]

: stetig, symmetrisch.

Erwartungswert: , Varianz:

Lognormalverteilung[Bearbeiten | Quelltext bearbeiten]

, . Y folgt Lognormalverteilung